Mastering 5G NR PHY

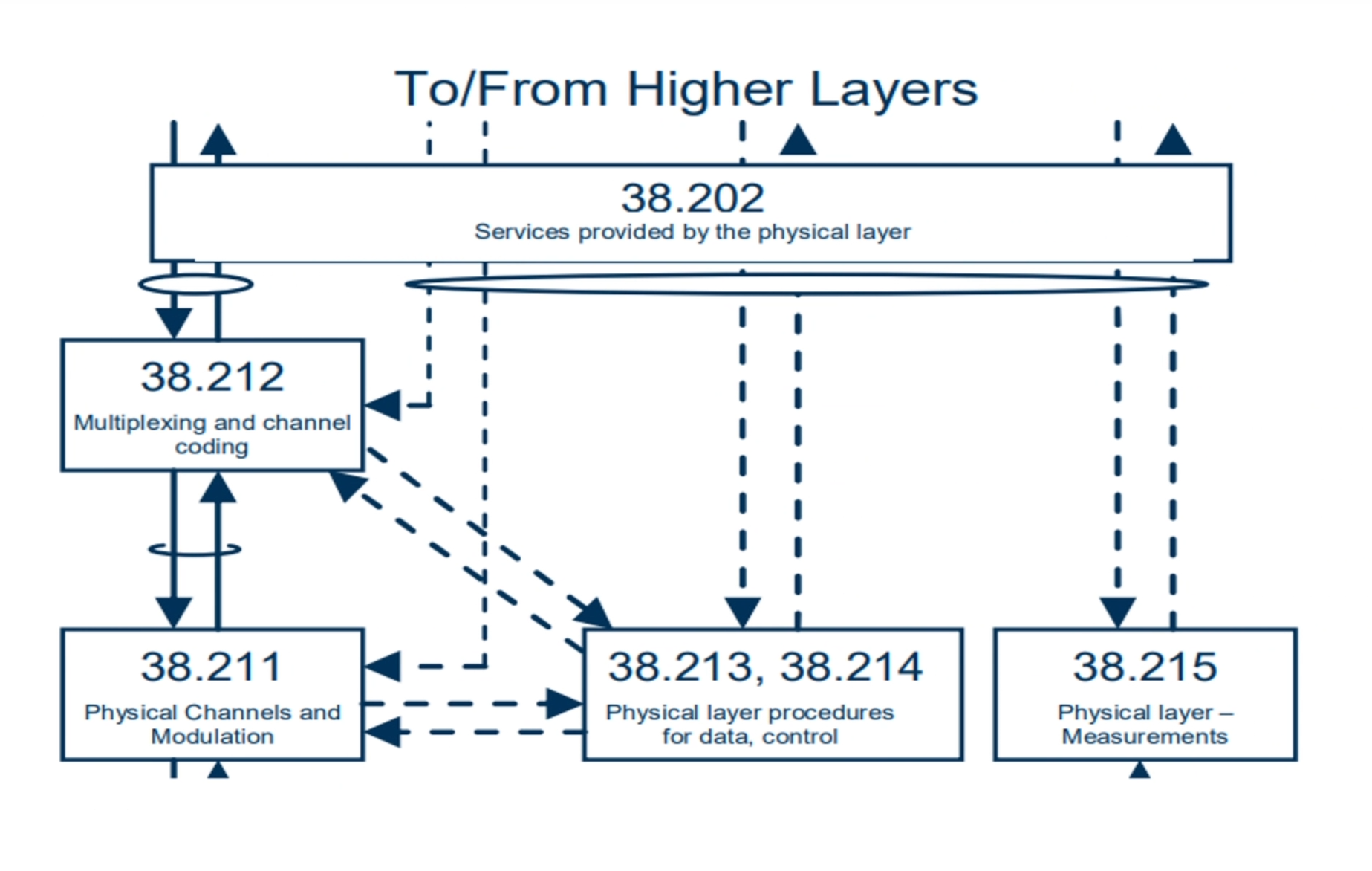

Technical specifications

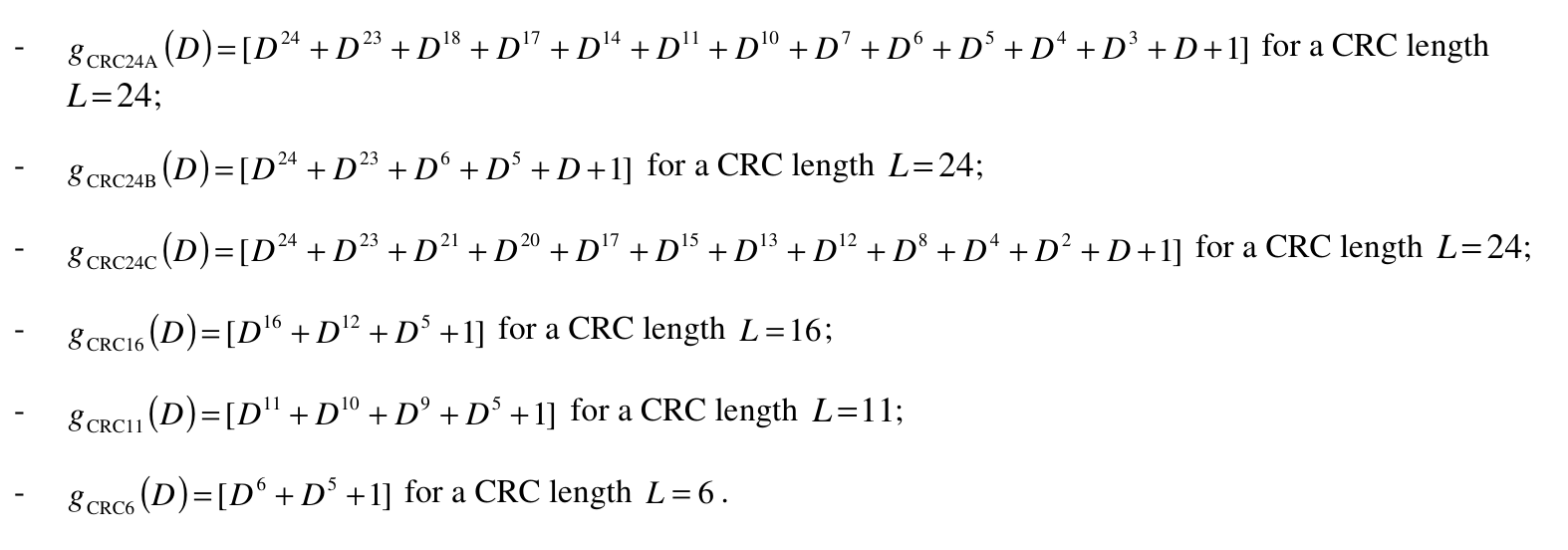

CRC (Cyclic Redundancy Check)

Channel Coding

- LDCP는 계산량이 많은데 비해 복잡도가 작고 앞단의 아웃풋을 뒷단의 인풋으로 하는 피드백 구조로 만들기가 쉽고 큰 데이터를 처리하는데 이득이 있어서 PUSCH, PDSCH와 같이 데이터 채널을 코딩하는데 사용됩니다.

- Pollar는 작은 데이터를 처리하는데 이득이 있어서 PUCCH 등 control data를 코딩하는데 사용됩니다.

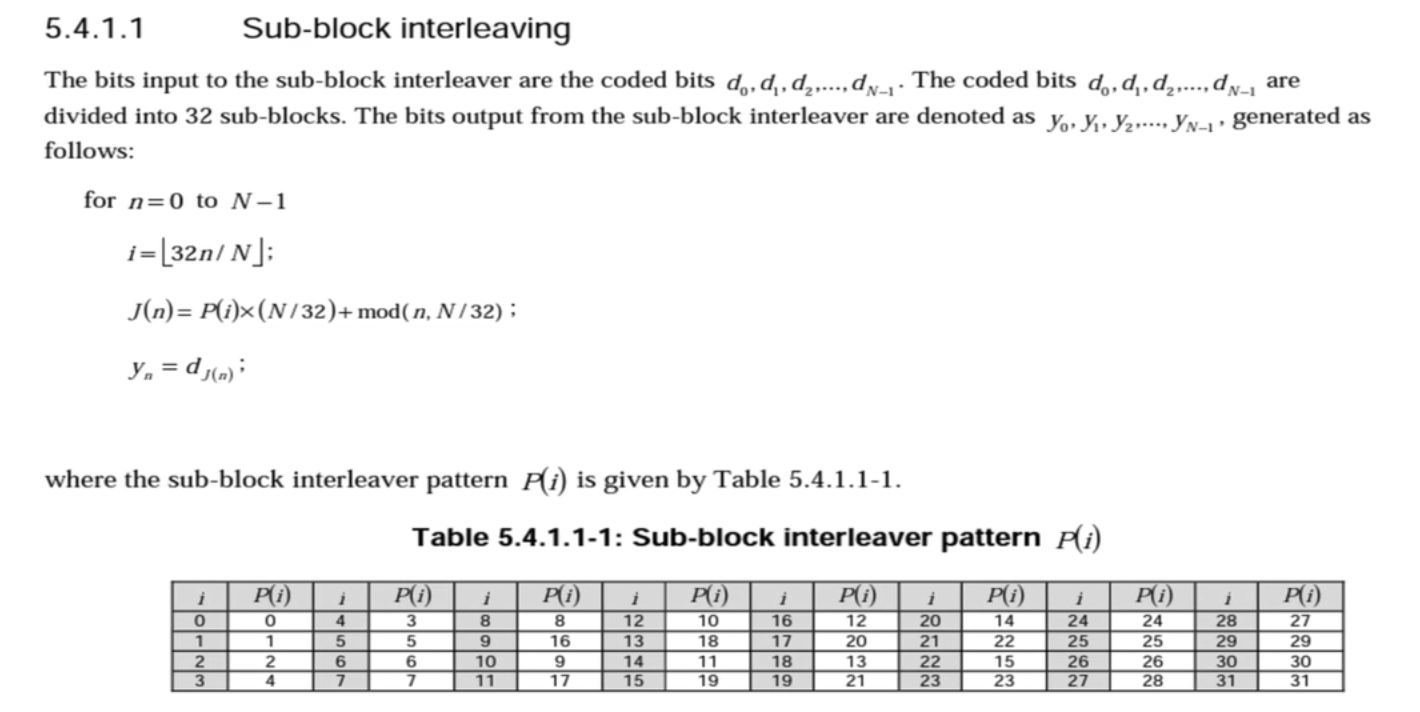

Rate matching

Modulations

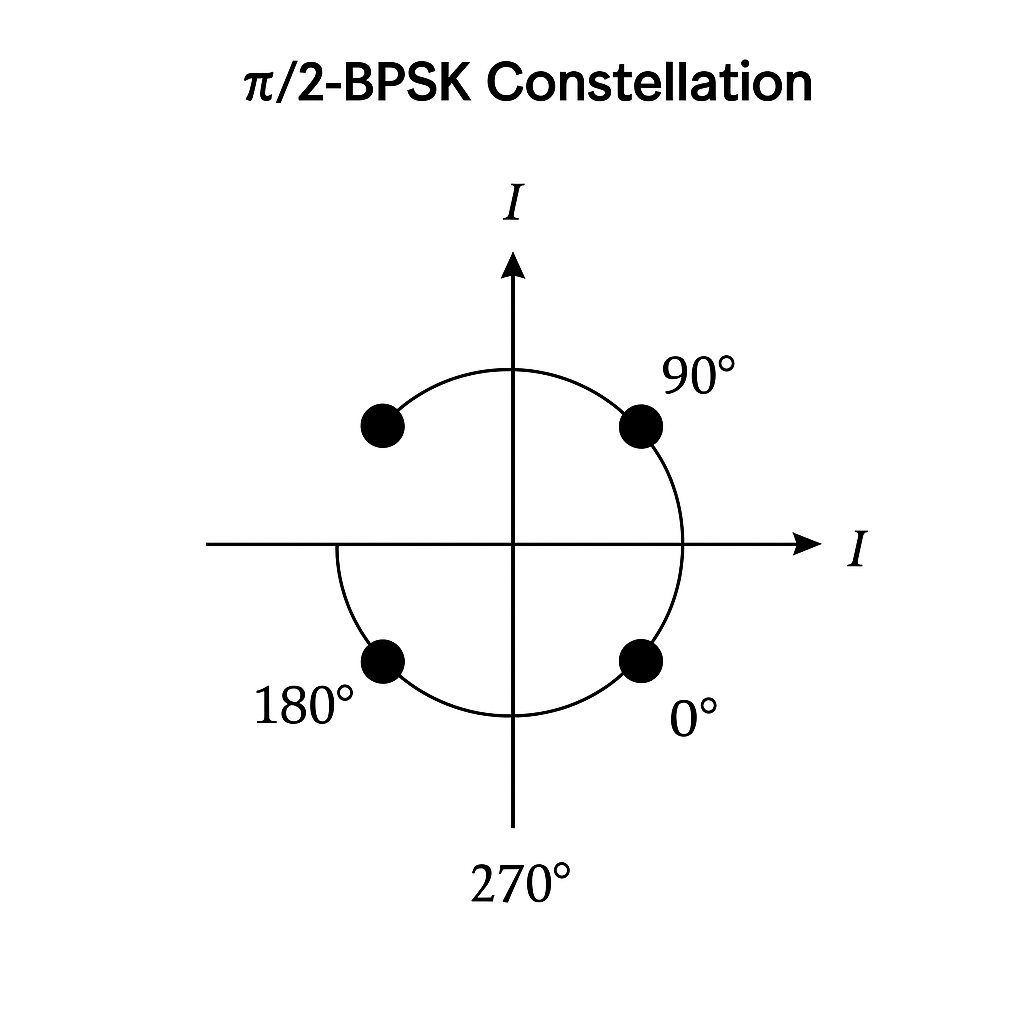

π/2-BPSK (Pi/2-Binary Phase Shift Keying) Modulation

기본 BPSK

일반 BPSK에서는 심볼이 두 가지 위상을 가집니다:

\[s_k = \begin{cases} +1, & \text{if bit = 0}\\ -1, & \text{if bit = 1} \end{cases}\]즉, 위상은 0° 또는 180°(π rad) 이고, 신호는 다음과 같이 표현됩니다:

\[s(t) = A \cos(2\pi f_c t + \phi_k)\]여기서

- A: 진폭

- $f_c$: 반송파 주파수

- $\phi_k$ = 0 또는 $\pi$

π/2-BPSK의 개념

π/2-BPSK에서는 심볼마다 위상을 π/2(=90°)만큼 회전시킵니다.

즉, 단순히 +1, −1을 사용하는 대신 각 심볼의 위상이 이전 심볼에서 π/2만큼 이동합니다.

\(s_k = a_k \cdot e^{j\theta_k}\) \(\theta_k = \theta_{k-1} + \frac{\pi}{2} \cdot (2a_k - 1)\)

결과적으로 신호의 궤적이 I-Q 평면에서 (1, 0) → (0, 1) → (−1, 0) → (0, −1) 형태로 순환하게 됩니다.

I/Q 신호 형태

| 심볼 순서 | I 성분 | Q 성분 | 위상 |

|---|---|---|---|

| 1 | +1 | 0 | 0° |

| 2 | 0 | +1 | 90° |

| 3 | −1 | 0 | 180° |

| 4 | 0 | −1 | 270° |

| 5 | +1 | 0 | 360° (=0°) |

👉 특징: I-축만 사용하는 BPSK와 달리, π/2-BPSK는 I와 Q축을 번갈아 사용하여 위상이 부드럽게 회전합니다.

장점

✅ DC 성분 제거 → 송신 신호의 스펙트럼 중심 왜곡이 적음

✅ 지속적인 위상 변화 → 송신 필터링 용이, PAPR 감소

✅ I/Q 불균형에 강함

✅ 5G NR, LTE Uplink 등에서 효율적

5G / LTE에서의 적용 예시

- LTE Uplink DMRS, 5G NR PUSCH DMRS는 π/2-BPSK 기반 시퀀스를 사용

- SC-FDMA(Uplink)에서 π/2-BPSK 변조 후 DFT-Spread OFDM 전송

- Bluetooth LE 등에서도 유사한 위상 회전 구조를 활용

시각적 예시 (I/Q 평면)

위상이 심볼마다 시계 방향 또는 반시계 방향으로 90°씩 회전하며, 신호가 원을 그리듯 이동합니다.

요약 비교

| 항목 | BPSK | π/2-BPSK |

|---|---|---|

| 위상 변화 | 0°, 180° | 매 심볼마다 ±90° 회전 |

| 신호 성분 | I-축만 사용 | I, Q 축 모두 사용 |

| DC 성분 | 존재 | 거의 없음 |

| PAPR | 높음 | 낮음 |

| 주요 응용 | 단순 디지털 통신 | LTE/5G Uplink, Bluetooth LE 등 |

요약 문장

π/2-BPSK는 BPSK의 단순성과 위상 연속성을 결합하여, DC 성분을 줄이고 송신 효율을 개선한 변조 방식이다.

LTE와 5G NR의 업링크 전송에서 널리 사용된다.

OFDM (Orthogonal Frequency Division Multiplexing)

기본 개념

- 하나의 고속 데이터 스트림을 여러 개의 저속 직교 부반송파(sub-carrier) 로 분할하여 전송하는 다중화 방식

- 여러 주파수 채널을 동시에 사용하는 디지털 변조 기술

필요성

- 다중경로 페이딩 및 주파수 선택적 감쇠 문제를 해결

- 각 부채널을 평탄한(frequency-flat) 채널로 간주 가능

- 복잡한 이퀄라이저 불필요

직교성 (Orthogonality)

- 부반송파 간 주파수 간격:

Δf = 1/T - 서로의 스펙트럼이 겹치더라도 간섭 없음 (내적 = 0)

- 하나의 신호가 1일 때 나머지 신호들은 모두 0

송신 과정

- 직렬 데이터 → 병렬 분할

- QPSK / 16QAM 등으로 변조

- IFFT로 부반송파 합성

- Cyclic Prefix (CP) 추가

- 아날로그 변환 후 송신

수신 과정

- CP 제거

- FFT로 부반송파 분리

- 복호화 및 병렬→직렬 변환

- 원래 데이터 복원

장점

- 다중경로 페이딩에 강함

- 높은 스펙트럼 효율

- FFT 기반 구현 용이

- 간섭 최소화

단점

- 높은 PAPR (Peak-to-Average Power Ratio)

- 주파수 오차와 위상 잡음에 민감

- 정밀한 동기화 필요

적용 사례

- Wi-Fi (IEEE 802.11a/g/n/ac/ax)

- LTE / 5G NR

- DVB-T / DAB

- Power Line Communication

요약

OFDM은 고속 데이터를 여러 직교 부반송파로 나누어 전송하는 기술로,

다중경로 환경에 강하고 효율적인 현대 무선 통신의 핵심 기술이다.

Multipath Propagation

다중경로 전파 (Multipath Propagation)

- 무선 신호가 건물, 지면, 차량, 나무 등 다양한 장애물에 반사·회절·산란되며

여러 경로(multiple paths) 로 수신기에 도달하는 현상입니다. - 이로 인해 신호가 시간 지연을 가지며 겹치고 간섭하게 되어,

페이딩(Fading) 또는 Multipath Fading 이 발생합니다.

Multipath의 주요 원인

- Reflection (반사): 벽, 지면 등에서 반사

- Diffraction (회절): 장애물 모서리를 돌아감

- Scattering (산란): 작은 입자나 불규칙한 표면에 의한 퍼짐

Multipath로 인한 문제

- ISI (Inter-Symbol Interference): 심볼 간 간섭

- 주파수 선택적 페이딩 (Frequency-Selective Fading)

- 수신 신호 품질 저하 및 에러율 증가

OFDM이 Multipath 문제를 해결하는 방법

- 부대역 분할 (Subcarrier Division)

- 전체 대역폭을 여러 개의 좁은 서브채널로 나누어,

각 부채널을 거의 평탄한 채널(frequency-flat channel) 로 만듭니다. - 따라서 복잡한 채널 이퀄라이저가 필요하지 않습니다.

- 전체 대역폭을 여러 개의 좁은 서브채널로 나누어,

- Cyclic Prefix (순환 접두사, CP)

- OFDM 심볼 앞부분에 심볼 끝부분 일부를 복사하여 붙입니다.

- 이렇게 하면 Multipath로 인한 지연이 CP 길이 이내일 경우,

ISI(심볼 간 간섭) 을 방지할 수 있습니다. - 또한, 채널을 순환(convolution) 형태로 만들어 FFT 처리가 가능해집니다.

- 직교성 유지 (Orthogonality)

- 부반송파 간 간섭을 제거하여 Multipath 환경에서도 안정적인 전송이 가능하게 합니다.

송신 과정 (Transmitter)

- 입력 데이터 직렬 → 병렬 분할

- QPSK / 16QAM 변조

- IFFT 로 부반송파 합성

- Cyclic Prefix 추가

- D/A 변환 후 송신

수신 과정 (Receiver)

- CP 제거

- FFT 로 부반송파 분리

- 복호화 및 병렬 → 직렬 변환

- 원래 데이터 복원

장점

- Multipath Fading에 강함

- 높은 스펙트럼 효율

- FFT/IFFT로 구현 용이

- 간섭 최소화

단점

- 높은 PAPR (Peak-to-Average Power Ratio)

- 주파수 오차 및 위상 잡음에 민감

- 정밀한 동기화 필요

요약

Multipath Propagation 은 신호가 여러 경로로 전파되어 간섭을 일으키는 현상이며,

OFDM 은 이를 부반송파 분할과 Cyclic Prefix 로 효과적으로 해결하는

현대 무선 통신의 핵심 기술이다.

Cyclic Prefix (CP)

정의

- OFDM 심볼의 마지막 일부를 복사하여 심볼 앞부분에 붙이는 구간

- Multipath 환경에서의 ISI(Inter-Symbol Interference) 를 방지하기 위한 보호 구간

역할

- Multipath로 인한 시간 지연을 흡수하여 ISI 방지

- CP 길이가 채널 지연 스프레드보다 길면, 지연 신호는 CP 안에서만 존재

- 본 심볼에는 간섭이 발생하지 않음

수학적 의미

- 선형 컨볼루션(linear convolution)을 순환 컨볼루션(circular convolution) 으로 변환

- FFT 기반 등화를 가능하게 함 → 간단하고 효율적인 주파수 영역 처리

동작 과정

- IFFT로 OFDM 심볼 생성

- 심볼의 마지막 일부를 복사

- 복사된 부분을 앞에 추가 → CP 생성

- 수신기에서는 CP 제거 후 FFT 수행

CP 길이 선택

- 채널 지연보다 길게 설정해야 함

- 너무 길면 효율 저하 → 일반적으로 1/4, 1/8, 1/16, 1/32 사용

- 예: LTE는 Normal CP / Extended CP 선택 가능

장점

- ISI 제거

- 주파수 영역 등화 용이

- 직교성 유지

단점

- 전송 효율 감소 (CP 구간은 데이터가 아님)

개념도

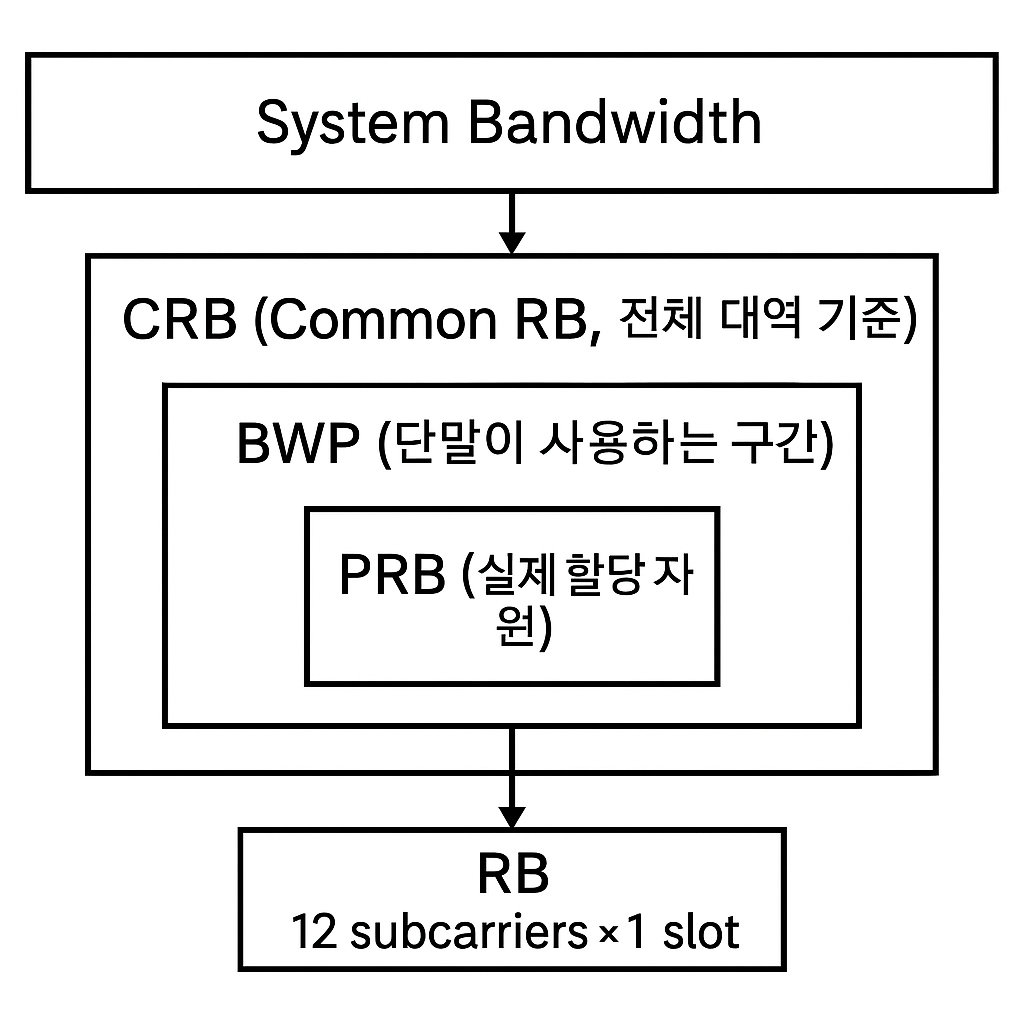

📡 5G NR / LTE 자원 단위 정리

Resource Block (RB)

- 시간-주파수 평면의 기본 자원 단위

- 구성: 12 subcarriers × 1 slot

- 약 180 kHz × 0.5 ms (LTE 기준)

- 데이터 전송의 최소 단위

Common Resource Block (CRB)

- 전체 시스템 대역폭 기준의 RB 인덱스

- 예: 100 MHz 시스템에 275 CRB 존재

- 전역 좌표로 RB 위치 표현

Physical Resource Block (PRB)

- 특정 BWP 내에서 실제로 할당되는 자원

- UE 입장에서 실제 사용되는 자원 단위

- CRB 중 BWP 범위 내에 속한 블록만 PRB로 매핑

Bandwidth Part (BWP)

- 전체 대역폭 중 일부를 단말이 사용하는 구간

- 전력 절감 및 유연한 대역폭 운용 목적

- 한 UE는 최대 4개의 BWP를 구성 가능

- 각 BWP는 자체 PRB 집합을 가짐

관계

System Bandwidth

└── CRB (전체 대역 기준)

└── BWP (단말이 사용하는 구간)

└── PRB (실제 할당 자원)

요약

| 용어 | 기준 | 설명 | | — | ——– | ———————– | | RB | 기본 단위 | 12 subcarriers × 1 slot | | CRB | 전체 대역 기준 | 시스템 전체 RB 위치 | | PRB | BWP 기준 | 실제 단말에 할당되는 RB | | BWP | 주파수 대역 | 단말이 사용하는 부분 대역 |

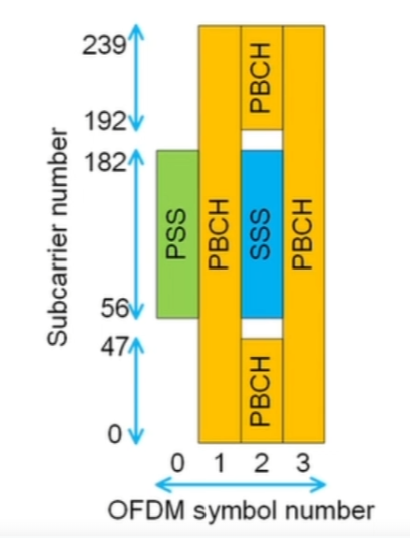

SSB (Signal Synchronization Block)

개요 — SSB란 무엇인가?**

SSB (Synchronization Signal Block) 은

단말(UE, User Equipment)이 5G 기지국(gNB) 을 처음 인식하고 동기화하기 위해 수신하는 기본 물리 신호 묶음입니다.

즉, UE가 “이 근처에 어떤 5G 셀이 있고, 어디 주파수·타이밍으로 동작 중인지” 를 알아내기 위한 셀 탐색(Synchronization & Cell Identification) 용 신호입니다.

SSB 구성 요소**

SSB는 아래 세 가지 신호로 구성됩니다.

| 구성요소 | 약어 | 역할 |

|---|---|---|

| Primary Synchronization Signal | PSS | 셀 ID 그룹 내 셀 식별(0~2) 및 타이밍 동기 |

| Secondary Synchronization Signal | SSS | 셀 그룹 ID (0~335) 및 프레임 동기 정보 제공 |

| Physical Broadcast Channel | PBCH | 시스템 파라미터 전달 (예: Subcarrier Spacing, Cell ID, System Frame Number, 등) |

즉,

SSB = PSS + SSS + PBCH

역할 정리

| 항목 | 설명 |

|---|---|

| PSS | 단말이 셀의 시간 동기를 잡고, 소그룹 내 Cell ID(0~2)를 인식 |

| SSS | 단말이 프레임 동기를 맞추고, 셀 그룹 ID(0~335)를 파악 |

| PBCH | 단말이 시스템 파라미터 (MIB 등) 을 디코딩하여 초기 접속 절차를 시작 |

SSB의 주파수 및 시간 배치

5G NR은 다양한 Subcarrier Spacing (SCS)에 따라 SSB의 위치와 주기(period) 가 다릅니다.

| Subcarrier Spacing | 사용 대역 | SSB 주기 | SSB 개수 (Beam 수) |

|---|---|---|---|

| 15 kHz / 30 kHz | FR1 (Sub-6GHz) | 기본 20 ms | 최대 4개 |

| 120 kHz | FR2 (mmWave) | 기본 20 ms | 최대 64개 |

- FR1: 저주파(Sub-6GHz) — 일반적으로 광범위 커버리지용

- FR2: 고주파(mmWave) — 빔포밍 기반 고속 데이터용

Beamforming과 SSB의 관계

5G는 빔포밍(Beamforming)을 사용하기 때문에,

기지국은 여러 방향(beam) 으로 SSB를 순차적으로 전송합니다.

이를 SS Burst Set 이라고 부르며,

한 세트 내에서 여러 개의 SS Block (SSB) 이 각기 다른 빔 방향으로 송신됩니다.

예를 들어:

- gNB가 8개의 빔 방향을 갖는다면 → 8개의 SSB를 주기적으로 송신

- 단말은 이 중 수신 세기가 가장 강한 빔 방향을 선택하여 동기화

셀 탐색(Cell Search) 절차

- PSS 탐색 → 타이밍 동기 획득

- SSS 탐색 → 프레임 동기 및 Cell ID 획득

- PBCH 디코딩 → MIB 수신 및 시스템 정보 획득

- RACH(Random Access Channel) 절차로 셀에 접속

SSB 구조 (시간-주파수 평면)

Frequency

↑

│

│ ┌───────────────┐

│ │ PBCH │ ← Physical Broadcast Channel

│ ├──────┬────────┤

│ │ PSS │ SSS │ ← Synchronization Signals

│ └──────┴────────┘

│──────────────────────────→ Time

- 총 4 OFDM Symbols (시간축)

- 240 Subcarriers (주파수축)

- 전체적으로 약 1 RB(=12 subcarriers) × 20 RB = 240 subcarriers

주요 파라미터 요약

| 항목 | 설명 |

|---|---|

| 구성 | PSS + SSS + PBCH |

| 주기 | 일반적으로 20 ms (configurable: 5, 10, 20 ms) |

| Subcarrier Spacing | FR1: 15/30 kHz, FR2: 120/240 kHz |

| 빔 수 | FR1 ≤ 4, FR2 ≤ 64 |

| 목적 | 셀 탐색, 동기화, 시스템 정보 획득 |

핵심 요약

SSB (Synchronization Signal Block) 는 5G NR에서 단말이 처음 셀을 인식하고

시간·주파수 동기를 맞춘 뒤 시스템 정보를 얻는 신호 묶음으로,

PSS, SSS, PBCH 로 구성되며 빔포밍 기반 다방향 송신 구조를 가집니다.

SSBurst

SS Burst란 무엇인가?

SS Burst (Synchronization Signal Burst) 는

5G 기지국(gNB)이 일정한 주기마다 하나 이상의 SSB(Synchronization Signal Block) 를 묶어서 한 세트로 송신하는 구조입니다.

즉,

여러 방향(beam)으로 송신되는 SSB들의 집합(Set) 이 바로 SS Burst 입니다.

SSB vs SS Burst vs SS Burst Set

| 구분 | 구성 요소 | 의미 | 관계 |

|---|---|---|---|

| SSB (Synchronization Signal Block) | PSS + SSS + PBCH | 단일 방향(beam)으로 송신되는 기본 블록 | 단위 신호 |

| SS Burst | 여러 개의 SSB 묶음 | 일정 주기(20 ms 등) 내에 연속적으로 송신되는 여러 SSB | 빔 탐색용 묶음 |

| SS Burst Set | 여러 SS Burst 묶음 | 더 큰 주기 내에서 반복되는 SS Burst들의 모음 | 전체 커버리지 탐색 단위 |

왜 SS Burst가 필요한가?

5G는 Massive MIMO + Beamforming 을 기반으로 하므로,

기지국이 여러 방향(beam) 으로 신호를 송신해야 합니다.

따라서 하나의 SSB만으로는 모든 방향의 단말을 커버할 수 없기 때문에,

기지국은 한 주기(예: 20 ms) 동안 여러 방향으로 SSB를 순차적으로 송신합니다.

이렇게 전송되는 모든 SSB들의 묶음이 바로 SS Burst 입니다.

SS Burst의 시간적 구조

예시 (FR1, Sub-6GHz)

- SSB는 4개까지 포함 가능

- 각 SSB는 서로 다른 빔 방향에 해당

- 하나의 SS Burst 주기: 기본 20 ms

- 각 SSB는 약 5 ms 간격으로 송신됨

예시 (FR2, mmWave)

- SSB는 최대 64개까지 포함 가능

- 매우 짧은 빔 간격으로 송신

- 여전히 하나의 SS Burst 주기는 20 ms

- 이후 동일 패턴으로 반복됨

SSB Index와 Beam Index

각 SSB는 고유의 SSB Index (0 ~ 63) 를 가집니다.

이 인덱스는 곧 Beam Index (빔 방향) 과 1:1로 대응합니다.

즉,

SSB #0→ 빔 방향 #0SSB #1→ 빔 방향 #1- …

SSB #63→ 빔 방향 #63

UE는 모든 SSB를 탐색해 가장 강한 빔 방향을 선택합니다.

SS Burst의 프레임 내 배치 (Time–Frequency Structure)

Time →

┌──────────────────────────────────────┐

│ SSB#0 │ SSB#1 │ SSB#2 │ SSB#3 │ ... │← 하나의 SS Burst(20 ms 주기)

└──────────────────────────────────────┘

- 각 SSB는 서로 다른 빔 방향으로 송신

- 여러 SSB로 구성된 SS Burst가 주기적으로 반복됨

- 전체적으로 SS Burst Set 이라는 상위 구조로 관리됨

주요 파라미터 요약

| 항목 | 설명 |

|---|---|

| 구성 | 여러 개의 SSB (최대 64개) |

| 주기 | 기본 20 ms (configurable: 5, 10, 20 ms) |

| 역할 | Beam 탐색 및 셀 검색 (Cell Search) 지원 |

| SSB 간 간격 | FR1: 최대 4개, FR2: 최대 64개 |

| 관련 파라미터 (3GPP 명시) | ssbPeriodicityServingCell, ssbSubcarrierSpacing, ssb-PositionsInBurst 등 |

셀 탐색에서의 관계 요약

SS Burst Set

└── SS Burst (주기적으로 반복)

└── 여러 SSB (서로 다른 빔 방향)

└── PSS + SSS + PBCH

즉,

SSB는 빔 단위 신호, SS Burst는 빔 집합, SS Burst Set은 반복 주기 단위 구조 입니다.

핵심 요약

SS Burst 는 5G NR에서 기지국이 여러 빔 방향으로 송신하는 SSB들의 묶음이며,

단말(UE)은 이 SS Burst를 탐색하여 가장 강한 빔 방향을 선택하고

초기 동기화 및 셀 접속 절차를 시작합니다.

PBCH and PBCH DMRS

@startuml

:PBCH Payload Generation;

:Scrambling;

:CRC Attachment;

:Polar coding;

:Rate matching;

:Scrambling;

:Modulation;

:RE mapping;

:IFFT and CP insertion;

@enduml

PSS, SSS, PBCH and DMRS mapping in SSB

위 그림에서 숫자는 Subcarrier number이고 D는 DMRS입니다. DMRS는 그림에서와 같이 PBCH에 존재하며 그 위치는 다음과 같이 결정됩니다.

위 그림에서 숫자는 Subcarrier number이고 D는 DMRS입니다. DMRS는 그림에서와 같이 PBCH에 존재하며 그 위치는 다음과 같이 결정됩니다.

📡 DMRS 위치의 수학적 표현 (5G NR)

기본 정의

- DMRS는 SSB 내 PBCH 구간에 존재.

- 위치와 시퀀스는 SSB Index와 Cell ID의 함수로 결정됨.

시퀀스 초기화 식 (3GPP TS 38.211 §7.4.1.4)

\(c_{init} = 2^{11} \times \left\lfloor \frac{N_{ID}^{cell}}{4} \right\rfloor + ( N_{ID}^{cell} \bmod 4 ) + 8 \times i_{SSB}\) → DMRS 시퀀스는 $N_{ID}^{cell}$ 과 $i_{SSB}$ 의 함수.

주파수 위치

\(f_{DMRS} = f_{carrier\_center} + k_{SSB}(i_{SSB}) + k_{DMRS,offset}\)

- $k_{SSB}(i_{SSB}) \text{ : SSB Index별 subcarrier offset}$

- $k_{DMRS,offset} \text{ : PBCH 내부의 DMRS 서브캐리어 오프셋}$

시간 위치

- 고정된 3번째 OFDM Symbol (symbol index = 2)

요약

| 항목 | 의존 변수 | 설명 | | —— | —————————- | ——————— | | 시퀀스 위상 | \(N_{ID}^{cell}, i_{SSB}\) | Gold sequence 초기화 | | 주파수 위치 | \(i_{SSB}\) | 빔별 Subcarrier offset | | 시간 위치 | 고정 | SSB의 세 번째 OFDM symbol |

따라서 DMRS의 위치와 시퀀스는 모두 SSB Index와 Physical Cell ID의 함수로 표현 가능하다.

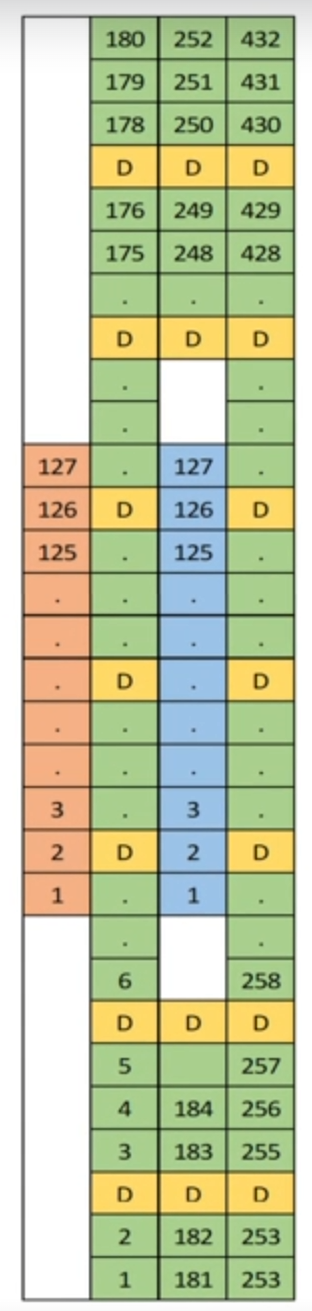

PRB (Physical Resource Block)

PRB란 무엇인가?

PRB (Physical Resource Block) 는

시간(time)과 주파수(frequency) 영역에서 단말(UE)에 실제로 할당되는 최소 물리 자원 단위입니다.

즉,

“무선 자원을 얼마나, 어디에 줄 것인가”를 결정할 때 기지국이 사용하는 기본 단위 블록이에요.

PRB의 기본 구조

| 영역 | 구성 요소 | 설명 |

|---|---|---|

| 주파수 영역 | 12 subcarriers | Subcarrier Spacing (SCS)에 따라 대역폭이 결정됨 |

| 시간 영역 | 1 slot (기본: 14 OFDM symbols) | 전송 단위 시간 |

| 결과적으로 | 12 subcarriers × 14 symbols | = 168 Resource Elements (REs) |

PRB의 대역폭 계산

각 PRB는 12개의 서브캐리어를 포함하므로, PRB 하나의 주파수 폭은 다음과 같습니다.

| Subcarrier Spacing (SCS) | PRB 대역폭 |

|---|---|

| 15 kHz | 180 kHz |

| 30 kHz | 360 kHz |

| 60 kHz | 720 kHz |

| 120 kHz | 1440 kHz |

따라서 5G NR은 SCS에 따라 PRB 폭이 달라집니다.

PRB의 역할

| 역할 | 설명 |

|---|---|

| 자원 할당 단위 | gNB가 UE에게 자원을 스케줄링할 때 “몇 개의 PRB”로 할당 |

| MCS 결정 기준 | 한 PRB 내 신호 품질(SINR)을 기준으로 변조 및 부호율 결정 |

| DMRS 배치 기준 | 참조신호(DMRS)는 PRB 구조에 맞춰 배치됨 |

| HARQ/CSI 보고 단위 | PRB 단위로 CQI, PMI, RI 등의 채널 정보를 보고 |

PRB vs RB vs CRB의 관계

| 용어 | 기준 | 설명 |

|---|---|---|

| RB (Resource Block) | 일반적 표현 | 시간–주파수 자원의 기본 블록 (이론적 개념) |

| CRB (Common Resource Block) | 전체 대역 기준 | 시스템 전체 대역에서의 RB 인덱스 (절대 위치) |

| PRB (Physical Resource Block) | BWP 기준 | UE에 실제 할당된 물리적 RB (상대 위치) |

📘 요약:

PRB = 실제 무선자원 단위 (BWP 내에서 UE가 사용하는 자원)

CRB = 시스템 전체 기준의 절대 위치

RB = 개념적 단위 (공통 용어)

PRB의 시간–주파수 평면 구조 (개념도)

Frequency ↑

│

│ ┌──────────────────────────────────────────────┐

│ │ 12 Subcarriers (Δf) │

│ ├──────────────────────────────────────────────┤

│ │ │

│ │ PRB (1 Slot) │

│ │ 14 OFDM Symbols × 12 Subcarriers │

│ │ │

│ └──────────────────────────────────────────────┘

│──────────────────────────────────────────────→ Time

- 세로축: 주파수 (12 subcarriers)

- 가로축: 시간 (1 slot = 14 OFDM symbols)

- 그 내부의 한 칸(1 subcarrier × 1 symbol)이 Resource Element (RE)

PRB 개수 예시 (대역폭에 따른 PRB 수)

| 대역폭 | 15 kHz SCS | 30 kHz SCS | 60 kHz SCS | 120 kHz SCS |

|---|---|---|---|---|

| 5 MHz | 25 PRB | 11 PRB | – | – |

| 10 MHz | 52 PRB | 24 PRB | – | – |

| 20 MHz | 106 PRB | 51 PRB | 24 PRB | – |

| 100 MHz | – | 273 PRB | 135 PRB | 66 PRB |

즉, PRB 수 = 주파수 대역폭 / (12 × SCS)

(단, 보호대역(guard band) 제외)

PRB는 실제 전송 자원 단위

PRB 내부에는 다양한 신호가 매핑됩니다.

| 종류 | 설명 |

|---|---|

| PDSCH / PUSCH | 실제 사용자 데이터 전송 |

| DMRS | 복조 기준신호 |

| PTRS / CSI-RS / SRS | 채널 품질 측정 신호 |

| Control (PDCCH / PUCCH) | 제어 정보 |

즉, PRB는 “데이터 + 참조 신호 + 제어 신호”가 함께 존재하는 물리적 전송 자원 단위입니다.

핵심 요약

| 항목 | 설명 | | ——- | ———————————— | | 정의 | 시간–주파수 영역의 최소 물리 자원 단위 | | 구성 | 12 Subcarriers × 1 Slot (14 Symbols) | | 대역폭 | SCS에 따라 180~1440 kHz | | 기준 | BWP 내 상대 위치 | | 역할 | 스케줄링, 채널 추정, 데이터 전송의 기본 단위 | | 수량 | 시스템 대역폭과 SCS에 따라 다름 |

PDCCH

@startuml

:DCI;

:CRC(CRC24C) Attachment;

:RNTI masking;

:Interleaving;

:Polar coding;

:Rate matching;

:Scrambling;

:Modulation;

:RE mapping;

:IFFT and CP insertion;

@enduml

PDCCH란 무엇인가?

PDCCH (Physical Downlink Control Channel) 는

단말(UE)에게 다운링크 및 업링크 전송 자원 할당 정보를 전달하는 제어 채널입니다.

즉,

“지금부터 이 PRB, 이 MCS, 이 타이밍으로 데이터를 보내줄게.”

“이 타이밍에 업링크로 데이터 보내.”

이런 명령이 모두 PDCCH 를 통해 전송됩니다.PDCCH의 주요 역할

| 역할 | 설명 |

|---|---|

| 1. Scheduling Information | 어떤 PRB에 데이터가 실리는지 (PDSCH/PUSCH 자원 할당) |

| 2. MCS Configuration | 변조방식(QPSK, 16QAM, 64QAM, 256QAM 등)과 부호율 정보 |

| 3. HARQ Control | 재전송 명령 (ACK/NACK), HARQ 프로세스 번호 전달 |

| 4. Timing Control | 전송 타이밍 지연 설정 |

| 5. Beam & BWP Info | 사용 중인 빔이나 Bandwidth Part 변경 정보 |

PDCCH의 계층 구조

PDCCH는 다른 채널들과 달리 “Control 영역” 에 존재하며,

논리/전송/물리 채널로 아래처럼 매핑됩니다.

| 계층 | 채널 이름 | 역할 |

|---|---|---|

| Logical Channel | DCCH (Dedicated Control Channel) | UE별 제어 논리 채널 |

| Transport Channel | DCI (Downlink Control Information) | 제어정보 패킷 형태 |

| Physical Channel | PDCCH | 실제 무선상으로 전송되는 제어 신호 |

즉,

UE는 PDCCH를 수신하고 내부에서 DCI를 디코딩하여 실제 제어명령을 해석합니다.

PDCCH 구조 (Time–Frequency Plane)

PDCCH는 CORESET (Control Resource Set) 영역 안에서 전송됩니다.

Frequency ↑

│

│ ┌────────────────────────────┐

│ │ CORESET │ ← Control Resource Set

│ │ ┌───────────┬───────────┐ │

│ │ │ PDCCH #1 │ PDCCH #2 │ │ ← 여러 UE의 제어 정보

│ │ └───────────┴───────────┘ │

│ └────────────────────────────┘

│──────────────────────────────→ Time

-

CORESET: PDCCH가 존재할 수 있는 “물리적 영역”

-

PDCCH: CORESET 내부의 일부 RE(Resource Element)에 매핑

-

PDSCH: CORESET 이후의 “Data 영역”에 존재

CORESET과 PDCCH의 관계

| 구성 요소 | 약어 | 설명 |

|---|---|---|

| CORESET (Control Resource Set) | CORESET | PDCCH가 위치할 수 있는 시간–주파수 영역 |

| Search Space (SS) | UE가 PDCCH를 탐색하는 후보 영역 | |

| CCE (Control Channel Element) | PDCCH를 구성하는 기본 단위 (6 REGs = 72 REs) | |

| DCI (Downlink Control Information) | 실제 제어정보 비트 시퀀스 (스케줄링 정보 포함) |

➡️ 요약 관계

CORESET → Search Space → CCE → PDCCH → DCI

Downlink/Uplink 제어 예시

| 목적 | PDCCH가 전달하는 내용 | 수신 후 단말 동작 |

|---|---|---|

| Downlink Scheduling | “PDSCH 할당 정보” | UE가 데이터 수신 |

| Uplink Grant | “PUSCH 자원 정보” | UE가 업링크 송신 |

| HARQ ACK/NACK | “재전송 요청 여부” | UE가 재전송 수행 |

| BWP/Beam 변경 | “활성화할 BWP, Beam ID” | UE가 전송 설정 변경 |

PDCCH의 물리적 구성 단위

| 단위 | 구성 | 설명 |

|---|---|---|

| RE (Resource Element) | 1 subcarrier × 1 symbol | 최소 자원 단위 |

| REG (Resource Element Group) | 12 REs | OFDM 상 한 Subcarrier 그룹 |

| CCE (Control Channel Element) | 6 REGs = 72 REs | PDCCH의 기본 구성 블록 |

| Aggregation Level (L) | CCE의 묶음 단위 (1, 2, 4, 8, 16) | 신호 강도에 따라 가변 |

즉,

PDCCH는 여러 CCE로 구성되고,

각 CCE는 6개의 REG (=72 REs)로 구성됩니다.

PDCCH 관련 파라미터 (3GPP 38.211/38.213)

| 파라미터 | 설명 |

|---|---|

| n_CCE | 사용된 Control Channel Element 개수 |

| L (Aggregation Level) | CCE 묶음 크기 |

| DCI Format | DCI 0_0, 1_0, 1_1 등 (전송 타입별 제어 포맷) |

| CORESET ID | CORESET 식별 번호 |

| SearchSpace ID | 탐색 공간 식별 번호 |

예시 (Downlink Scheduling Flow)

- gNB가 UE에 PDSCH 자원을 할당해야 함

2️. DCI(포맷 1_0) 생성

3️. DCI를 CCE에 매핑하여 PDCCH로 전송

4️. UE가 Search Space에서 해당 PDCCH를 탐색 및 디코딩

5️. DCI 정보로 PDSCH 위치·MCS·HARQ 설정

6️. PDSCH에서 데이터 수신

핵심 요약

| 항목 | 설명 |

|---|---|

| 이름 | PDCCH (Physical Downlink Control Channel) |

| 역할 | 자원 할당, HARQ, BWP/Beam 제어 등 |

| 위치 | CORESET 영역 내 |

| 기본 단위 | CCE (Control Channel Element) |

| 탐색 방식 | Search Space 기반 |

| 전송 정보 | DCI 포맷 (0_0, 1_0, 1_1 등) |

DCIs

DCI란 무엇인가?

DCI (Downlink Control Information) 는

단말(UE)에게 무선자원 스케줄링과 제어 명령을 전달하는 정보 포맷입니다.

즉,

PDCCH가 껍질(shell) 이라면,

DCI는 그 안에 들어 있는 핵심 제어 메시지(payload) 입니다.

DCI의 역할

| 역할 | 설명 |

|---|---|

| 다운링크 스케줄링 | UE에게 어떤 PRB, 어떤 MCS로 데이터를 수신해야 하는지 알려줌 |

| 업링크 스케줄링 (UL Grant) | UE에게 업링크 전송용 자원을 할당 |

| HARQ 제어 | 재전송(ACK/NACK) 및 프로세스 번호 제어 |

| 파워 제어 | 전송 전력 보정 지시 |

| BWP / Beam 제어 | 활성화할 Bandwidth Part 및 빔 정보 |

| CSI 요청 | 채널 상태 정보(CQI/PMI/RI) 보고 명령 |

DCI의 전송 구조

DCI는 PDCCH를 통해 전송됩니다.

아래 구조로 계층이 연결되어 있어요:

CORESET → Search Space → PDCCH → DCI

즉:

- PDCCH = 물리 계층 전송 신호

- DCI = 그 안에 담긴 제어 정보 (bit field format)

DCI의 주요 포맷 (5G NR 기준)

DCI에는 여러 포맷이 정의되어 있습니다.

각 포맷은 전송 방향(DL/UL)과 전송 타입(공유, 공용, 특정 UE)에 따라 달라집니다.

| DCI 포맷 | 방향 | 역할 / 설명 |

|---|---|---|

| Format 0_0 | UL | UL-SCH 자원 할당 (기본 UL grant) |

| Format 0_1 | UL | Configured Grant 방식 자원 할당 |

| Format 1_0 | DL | DL-SCH 자원 할당 (기본 DL scheduling) |

| Format 1_1 | DL | Semi-persistent scheduling (SPS) 또는 고급 DL 설정 |

| Format 2_0~2_3 | DL | Power Control, CSI 요청 등 기타 제어용 |

| Format 3_0 / 3_1 | DL | Group-based scheduling / Power offset 제어 |

| Format 4_0 | DL | Beam activation / deactivation |

| | Fallback DCIs | Non-fall DCIs | | ——— | ————- | ————- | | PUSCH | DCI 0_0 | DCI 0_1 | | PDSCH | DCI 1_0 | DCI 1_1 |

- DCI 0_1와 DCI 1_1의 크기가 DCI 0_0과 DCI 1_1 보다 큽니다.

- DCI 0_1과 DCI 1_1은 zero padding이 삽입됩니다.

- DCI 0_0과 DCI 1_0은 single layer 입니다.

- DCI 0_1과 DCI 1_1은 multi layer 입니다.

DCI의 주요 필드 구성

예시: DCI Format 1_0 (Downlink Scheduling)

| 필드명 | 설명 |

|---|---|

| Carrier Indicator | 다중 캐리어 사용 시 어떤 Carrier인지 표시 |

| Bandwidth Part (BWP) Indicator | 활성화할 BWP ID |

| Resource Allocation | PRB 자원 할당 정보 (bitmap 또는 type1/2) |

| MCS (Modulation and Coding Scheme) | 변조방식 및 부호율 |

| HARQ Process Number | 현재 HARQ 버퍼 식별자 |

| New Data Indicator (NDI) | 새 데이터 전송 여부 표시 |

| Redundancy Version (RV) | HARQ 재전송 시 부호율 패턴 |

| Power Control Commands | 전송 전력 보정 값 |

| Time-domain Resource Assignment | 어떤 슬롯/심볼에 전송할지 |

| DMRS Configuration | 참조 신호 패턴 |

| CSI Request | 채널 상태 보고 요청 |

⚠️ 각 DCI 포맷마다 비트 필드 구성이 다르며,

실제 비트 길이는 DCI Format + Bandwidth + RNTI 종류에 따라 달라집니다.

DCI의 인코딩 및 디코딩 과정

[1] gNB (송신측)

- MAC/RRC 계층에서 스케줄링 정보 생성

- DCI 포맷에 따라 비트 필드 구성

- CRC 추가 및 RNTI (Radio Network Temporary Identifier) 마스킹

- DCI를 PDCCH에 매핑

- OFDM 변조 → 무선 전송

[2] UE (수신측)

- Search Space 내에서 PDCCH 탐색

- CRC 마스크를 통해 자신에게 해당하는 DCI 확인

- DCI 비트 디코딩 및 해석

- 자원 재구성 및 데이터 수신 준비 (PDSCH 또는 PUSCH)

RNTI (Radio Network Temporary Identifier)

- DCI는 CRC를 RNTI로 마스킹하여 UE 구분을 수행합니다.

- RNTI의 종류에 따라 DCI의 목적이 달라짐:

| RNTI 종류 | 용도 |

|---|---|

| C-RNTI | 개별 UE 전용 제어 |

| SI-RNTI | 시스템 정보(SIB) 전송 |

| P-RNTI | 페이징(Paging) 메시지 |

| RA-RNTI | 랜덤 액세스 (RACH) 응답 |

| TC-RNTI | 일시적인 연결 중 식별자 |

DCI 전송의 시간적 관계

Slot n:

├─ PDCCH (DCI Format 1_0) → PDSCH Scheduling

├─ PDCCH (DCI Format 0_0) → PUSCH Grant

Slot n+k:

└─ PDSCH/PUSCH 실제 데이터 전송

즉,

DCI는 데이터 전송보다 먼저(slot advance) 전송되어

UE가 미리 전송 자원을 준비하도록 합니다.

DCI와 PDCCH 관계 요약

| 항목 | 설명 |

|---|---|

| PDCCH | DCI가 담기는 물리 채널 |

| DCI | 자원 및 제어 정보 (bit field) |

| CORESET | PDCCH가 존재할 수 있는 시간–주파수 영역 |

| Search Space | UE가 자신에게 해당하는 DCI를 찾는 후보 영역 |

핵심 요약

| 항목 | 설명 |

|---|---|

| DCI 정의 | 무선자원 제어 정보 (Scheduling, HARQ, Power, CSI 등) |

| 전송 채널 | PDCCH (물리 채널) |

| 포맷 종류 | Format 0_x (UL), 1_x (DL), 2_x~4_x (Control) |

| 기본 단위 | 비트 필드 구조, CRC 마스크(RNTI) |

| 수신 절차 | UE가 Search Space 내 PDCCH를 탐색 후 DCI 디코딩 |

| 결과 | UE는 DCI 기반으로 PDSCH/PUSCH 송수신 수행 |

CORESET

CORESET이란 무엇인가?

CORESET (Control Resource Set) 은

5G NR에서 PDCCH(Physical Downlink Control Channel) 가 전송될 수 있는

시간–주파수 영역(time-frequency region) 을 정의한 영역입니다.

즉,

“PDCCH는 아무 곳에나 존재하지 않고, 정해진 CORESET 안에서만 존재할 수 있습니다.”

CORESET의 역할

| 역할 | 설명 |

|---|---|

| 제어 신호 위치 정의 | PDCCH가 놓일 수 있는 시간–주파수 영역 정의 |

| 제어 자원 분리 | 다른 채널(PDSCH 등)과의 간섭 방지 |

| 유연한 스케줄링 | 주파수, 시간, 심볼 개수, RE 패턴을 자유롭게 구성 가능 |

| UE별 맞춤 제어공간 제공 | 각 UE에게 다른 CORESET을 할당할 수 있음 |

CORESET의 구성 요소

CORESET은 시간 영역(OFDM symbol 수) 과 주파수 영역(Resource Block 수) 으로 정의됩니다.

| 항목 | 설명 |

|---|---|

| 시간 영역 | 1, 2, 또는 3 OFDM symbols |

| 주파수 영역 | 6의 배수로 구성된 RB 단위 (예: 24, 48, 96 RB 등) |

| RE(Resource Element) | Subcarrier × Symbol 단위 |

| REG(Resource Element Group) | 12 RE = 1 REG |

| CCE(Control Channel Element) | 6 REG = 1 CCE |

- 1 REG에는 12개의 RE가 있지만 그 중 3개에는 DMRS가 있으므로 9개의 RE가 있습니다.

- 1 CCE는 6 REG입니다.

CORESET과 PDCCH의 관계

CORESET → REG → CCE → PDCCH → DCI

- CORESET: 제어 신호가 존재할 수 있는 물리적 “그릇”

- REG: 12 RE로 구성된 작은 그룹

- CCE: PDCCH의 기본 구성 블록 (6 REG = 72 RE)

- PDCCH: 실제 제어 정보가 매핑되는 채널

- DCI: PDCCH에 담기는 제어 정보 (payload)

CORESET의 주요 파라미터 (3GPP 38.211 §7.3.2.2)

| 파라미터 | 의미 | 설명 |

|---|---|---|

| CORESET ID | 식별 번호 | 0~11까지 식별 가능 (RRC로 구성됨) |

| Duration | 심볼 개수 | 1, 2, 3 OFDM symbols 중 하나 |

| Frequency Domain Resources | 주파수 영역 | 6 RB 단위로 정의된 bitmap |

| CCE-to-REG mapping | 매핑 방식 | Interleaved 또는 Non-interleaved |

| DMRS Configuration | 참조신호 패턴 | PDCCH 복조용 DMRS 포함 |

CORESET의 시간–주파수 구조 (예시)

Frequency

↑

│

│ ┌─────────────────────────────────────────────┐

│ │ CORESET │

│ │ ┌───────────────┬───────────────┬─────────┐ │

│ │ │ PDCCH UE#1 │ PDCCH UE#2 │ PDCCH#3 │ │

│ │ └───────────────┴───────────────┴─────────┘ │

│ └─────────────────────────────────────────────┘

│────────────────────────────────────────────────→ Time

│ (1~3 OFDM Symbols)

- CORESET의 크기(시간×주파수)는 유연하게 설정 가능

- 한 CORESET 내부에 여러 UE의 PDCCH가 존재할 수 있음

- CORESET은 PDSCH (데이터 채널) 이전에 항상 전송됨

Search Space와 CORESET의 관계

CORESET은 물리적 영역, Search Space 는 UE가 그 영역 안에서 “어디를 탐색할지”를 정의한 논리적 영역입니다.

| 구성 요소 | 설명 |

|---|---|

| CORESET | PDCCH가 실제 존재할 수 있는 물리 자원 영역 |

| Search Space (SS) | UE가 해당 CORESET 내에서 DCI를 탐색하는 후보 영역 |

| Aggregation Level (L) | CCE 묶음 크기 (1, 2, 4, 8, 16) |

| SearchSpaceSet | 여러 Search Space 묶음 (예: Common, UE-specific) |

👉 관계 요약:

CORESET (물리 영역)

└── Search Space (탐색 후보)

└── CCE (PDCCH 구성 단위)

└── DCI (제어정보)

CORESET의 종류

| 구분 | 이름 | 특징 |

|---|---|---|

| CORESET #0 | 공통 (Common) | 셀 탐색 및 시스템 정보용 (SI-RNTI, RA-RNTI 등) |

| CORESET #1~11 | 전용 (UE-specific) | UE별 동적 자원 제어용 (C-RNTI 기반) |

📘 예시:

- CORESET #0: SSB 이후의 초기 PDCCH 전송용

- CORESET #1: 연결 이후 스케줄링용

CORESET 내 REG/CCE 매핑

CORESET 내 PDCCH 자원은 REG 단위로 구성되며,

이들은 Interleaved 또는 Non-interleaved 방식으로 CCE에 매핑됩니다.

| 매핑 방식 | 설명 |

|---|---|

| Non-Interleaved | 연속된 REG를 묶어 하나의 CCE 구성 (단순, 고신뢰) |

| Interleaved | REG를 주파수 전반에 퍼뜨려 페이딩에 강함 (분산형) |

DCI 수신 절차에서 CORESET의 역할

1️. UE는 RRC 메시지로 CORESET 구성을 수신

2️. Search Space 구성을 통해 탐색 영역 설정

- CORESET 내에서 PDCCH 탐색 수행

4️. CRC 마스크로 자신의 RNTI 확인

5️. 해당 DCI 해석 → 자원 할당 수행

핵심 요약

| 항목 | 설명 |

|---|---|

| 정의 | PDCCH가 전송될 수 있는 시간–주파수 영역 |

| 구성 단위 | REG → CCE → PDCCH |

| 시간 길이 | 1~3 OFDM symbols |

| 주파수 폭 | 6 RB 단위, bitmap으로 정의 |

| 매핑 방식 | Interleaved / Non-interleaved |

| 역할 | PDCCH 및 DCI의 전송 영역 제공 |

| 종류 | Common (CORESET#0), UE-specific (CORESET#1~11) |

CORESET의 크기

기본 관계식

5G NR에서 다음과 같은 관계가 항상 성립합니다: \(N_{CCE} = \frac{N_{REG}}{6}\) 즉,

- 1 CCE = 6 REG

- 1 REG = 12 RE (Resource Elements)

- 따라서 \(\text{1 CCE} = 6×12 = \text{72 RE}\) —

REG 개수 계산식

CORESET 내의 REG 개수 (N_REG) 는 다음과 같이 계산됩니다: \(N_{REG} = N_{RB}^{CORESET} × N_{sym}^{CORESET}\)

| 기호 | 의미 | 설명 |

|---|---|---|

| \(N_{RB}^{CORESET}\) | 주파수 방향의 RB 개수 | CORESET 폭 (6의 배수) |

| \(N_{sym}^{CORESET}\) | 시간 방향의 OFDM symbol 개수 | 1, 2, 또는 3 |

따라서, CORESET 내 CCE 수는

\[N_{CCE} = \frac{N_{RB}^{CORESET} × N_{sym}^{CORESET}}{6}\]📊 4️⃣ 예시 계산

| CORESET 구성 (주파수 × 시간) | REG 수 | CCE 수 (N_CCE) |

|---|---|---|

| 24 RB × 1 symbol | 24 | 4 |

| 24 RB × 2 symbols | 48 | 8 |

| 48 RB × 2 symbols | 96 | 16 |

| 48 RB × 3 symbols | 144 | 24 |

| 96 RB × 2 symbols | 192 | 32 |

| 96 RB × 3 symbols | 288 | 48 |

| 144 RB × 3 symbols | 432 | 72 |

실제 예시 (3GPP NR 표준에서 자주 쓰는 CORESET 크기)

| CORESET ID | 시간 길이 | RB 폭 | 총 CCE 개수 | 설명 |

|---|---|---|---|---|

| CORESET #0 | 2 symbols | 48 RB | 16 CCE | 초기 접속용 (공통) |

| CORESET #1 | 2 symbols | 96 RB | 32 CCE | 일반 DL 스케줄링용 |

| CORESET #2 | 3 symbols | 48 RB | 24 CCE | UE 전용 PDCCH 영역 |

| CORESET #3 | 1 symbol | 24 RB | 4 CCE | 소형 셀 또는 협대역 제어용 |

요약 도식

CORESET (time × frequency)

└── REG (12 RE)

└── 6 REG = 1 CCE

└── 여러 CCE로 PDCCH 구성

핵심 요약

| 항목 | 설명 |

|---|---|

| 1 CCE | 6 REG = 72 RE |

| 1 REG | 12 RE |

| CCE 개수 계산식 | \(N_{CCE} = (N_{RB}^{CORESET} × N_{sym}^{CORESET}) / 6\) |

| CORESET 길이 | 1–3 OFDM Symbols |

| CORESET 폭 | 6 RB 단위 (최대 275 RB, 표준 상 최대 48 CCE 정도 권장) |

| 예시 | CORESET (48 RB × 2 sym) = 16 CCE |

Search Space

Search Space란 무엇인가?

Search Space (SS) 는

단말(UE)이 PDCCH(=DCI가 들어있는 제어 신호) 를 탐색할 후보 영역(candidate region) 을 의미합니다.

즉,

“CORESET이 PDCCH가 실제 존재할 수 있는 물리적 영역”이라면,

“Search Space는 UE가 그 영역 안에서 자신에게 해당하는 제어정보를 찾아보는 논리적 영역”이에요.

핵심 개념 비교

| 구분 | 역할 | 설명 |

|---|---|---|

| CORESET | 물리적 영역 | PDCCH가 실제 존재할 수 있는 시간–주파수 자원 (OFDM symbols × RB) |

| Search Space (SS) | 논리적 영역 | UE가 CORESET 내에서 PDCCH/DCI를 탐색하는 후보 집합 |

즉 👇

CORESET (물리적 컨테이너)

└── Search Space (탐색 후보 구역)

└── 여러 Candidate CCE 묶음

└── PDCCH (DCI 포함)

Search Space의 주요 역할

| 역할 | 설명 |

|---|---|

| PDCCH 탐색 후보 정의 | UE가 어떤 CCE 집합에서 PDCCH를 디코딩할지 결정 |

| 제어 채널 충돌 방지 | 여러 UE가 같은 CORESET을 공유할 때 충돌 방지 |

| 다양한 제어 시나리오 지원 | 공통 제어(시스템 정보, 페이징 등)와 UE 전용 제어 모두 지원 |

| Aggregation Level 관리 | CCE 묶음 크기를 정의 (1, 2, 4, 8, 16 CCE 단위) |

Search Space의 주요 파라미터

3GPP TS 38.213 §10.1 에 정의된 주요 설정 요소입니다:

| 파라미터 | 설명 |

|---|---|

| SearchSpace ID | Search Space 식별자 |

| CORESET ID | 연결된 CORESET 식별자 (Search Space는 항상 하나의 CORESET과 연결됨) |

| n_CandidatesPerAggLevel | 각 Aggregation Level별 후보 개수 (예: 2, 4, 8 등) |

| Aggregation Level (L) | CCE 묶음 크기 (1, 2, 4, 8, 16) |

| Monitoring Slots | PDCCH 탐색이 수행되는 슬롯 위치 |

| RNTI Type | 어떤 RNTI로 CRC 마스크가 되는지 (예: C-RNTI, SI-RNTI, RA-RNTI 등) |

Search Space의 종류

5G NR에는 크게 두 종류의 Search Space가 있습니다.

| 종류 | 이름 | 설명 |

|---|---|---|

| Common Search Space (CSS) | 공통 탐색 영역 | 시스템 공용 메시지(SIB), 페이징, 랜덤 액세스 응답 등 |

| UE-Specific Search Space (USS) | 전용 탐색 영역 | 특정 UE의 DL/UL 스케줄링, HARQ 등 |

📘 예시

- CSS: SI-RNTI, P-RNTI, RA-RNTI, C-RNTI (초기용)

- USS: C-RNTI, TC-RNTI (연결된 단말용)

Aggregation Level (L)

Search Space 내에서 PDCCH는 하나 이상의 CCE 묶음(Aggregation Level) 로 전송됩니다.

| Aggregation Level (L) | 사용 CCE 개수 | 설명 |

|---|---|---|

| 1 | 1 CCE | 좋은 채널 상태 (짧은 제어 메시지) |

| 2 | 2 CCE | 중간 채널 상태 |

| 4 | 4 CCE | 약한 채널 환경 |

| 8 / 16 | 8 / 16 CCE | 매우 약한 채널 환경, 높은 신뢰 필요 |

단말은 Search Space 내의 여러 후보 중 하나가 자신에게 해당하는 DCI일 수 있으므로,

각 Aggregation Level별 후보를 blind decoding 해야 합니다.

Blind Decoding (맹목 디코딩)

-

UE는 Search Space 내에서 가능한 모든 CCE 조합(aggregation level 후보)에 대해

PDCCH를 시도적으로 디코딩합니다. -

DCI의 CRC를 RNTI로 마스크 해제하여

자신의 RNTI와 일치하는지 확인합니다.

즉 👇

UE는 Search Space 내 여러 위치에서 “혹시 나한테 온 PDCCH 있나?” 하고 전부 검사(blind decoding)합니다.

Search Space 구성 예시

| 파라미터 | 예시 값 |

|---|---|

| 연결된 CORESET | CORESET #1 |

| Duration | 2 OFDM symbols |

| Aggregation Levels | {2, 4, 8} |

| Candidates per Level | {4, 2, 1} |

| RNTI Type | C-RNTI |

| Monitoring Slots | Slot 0, 2, 4, … |

➡️ 이 경우 UE는 Slot 0, 2, 4 등에서

CORESET#1 내 지정된 후보 CCE 위치에서만 PDCCH를 탐색합니다.

Search Space와 CORESET 관계 정리

| 개념 | 의미 | 역할 |

|---|---|---|

| CORESET | 물리적 제어 영역 | PDCCH가 실제 배치되는 공간 |

| Search Space | 논리적 탐색 영역 | UE가 PDCCH를 찾는 후보 구간 |

| PDCCH | 물리 채널 | DCI를 실어서 전송 |

| DCI | 제어 정보 | 스케줄링·HARQ·MCS 정보 등 |

📘 관계 구조:

CORESET

└── Search Space

└── CCE Candidates

└── PDCCH (contains DCI)

핵심 요약

| 항목 | 설명 |

|---|---|

| 정의 | CORESET 내에서 UE가 PDCCH/DCI를 탐색하는 논리적 후보 영역 |

| 유형 | Common Search Space (CSS), UE-Specific Search Space (USS) |

| Aggregation Level | 1, 2, 4, 8, 16 CCE 단위 |

| 탐색 방식 | Blind Decoding (RNTI 기반 CRC 확인) |

| CORESET과의 관계 | Search Space는 항상 하나의 CORESET과 연결 |

| 역할 | PDCCH 충돌 방지 및 제어 효율 향상 |

Blind decoding

이 개념은 단말(UE)이 “자신에게 해당하는 제어 메시지(DCI)가 어디 있는지 모를 때, 그것을 어떻게 찾는가” 하는 문제의 핵심입니다.

Blind Decoding이란 무엇인가?

Blind Decoding (맹목 디코딩) 은

단말(UE)이 Search Space 내의 모든 가능한 위치, 크기, 포맷 후보에 대해 PDCCH(DCI) 를 시도적으로(decoding attempt) 디코딩하여,

자신에게 해당하는 제어 메시지를 찾아내는 과정입니다.

즉 👇

UE는 “PDCCH가 어디에 있고, 어떤 형식(DCI format)으로 왔는지 미리 모른다.”

그래서 “가능한 모든 후보를 일일이 시도해보며(맹목적으로) 자신에게 온 메시지를 찾는” 겁니다.

왜 Blind Decoding이 필요한가?

5G NR의 제어 채널 구조는 매우 유연합니다.

- PDCCH는 CORESET 내 임의의 위치에 배치될 수 있고,

- 크기(=Aggregation Level)도 1, 2, 4, 8, 16 CCE 등 다양하며,

- DCI 포맷도 여러 가지(예: 0_0, 1_0, 1_1 등)가 존재하죠.

따라서 UE는 수신 시점에 다음을 모릅니다:

- DCI가 존재하는지 여부

- 존재한다면 어디에 위치하는지

- 얼마나 많은 CCE를 사용하는지 (Aggregation Level)

- 어떤 DCI 포맷인지

👉 그래서 UE는 “모든 가능한 후보 조합”을 맹목적으로 디코딩해서 확인해야 합니다.

Blind Decoding의 과정 요약

1️. UE는 Search Space 설정에 따라 후보 위치(=CCE 집합)들을 알고 있음.

2️. 각 후보에 대해, 가능한 Aggregation Level (1, 2, 4, 8, 16)을 적용.

3️. 각각의 후보 CCE 묶음에 대해 DCI 디코딩 시도 수행.

4️. 디코딩된 DCI의 CRC를 RNTI로 마스크 해제.

5️. CRC 결과가 자신의 RNTI와 일치하면 → 성공!

6️. 일치하지 않으면 → 다음 후보로 이동.

절차 도식

Search Space 내 여러 후보 CCE 집합들

├─ 후보 #1 (L=2 CCE) → 디코딩 → CRC=RNTI? → No

├─ 후보 #2 (L=4 CCE) → 디코딩 → CRC=RNTI? → No

├─ 후보 #3 (L=8 CCE) → 디코딩 → CRC=RNTI? → ✅ Yes → DCI 수신 성공

└─ 후보 #4 (L=2 CCE) → 스킵

UE는 자신에게 해당하는 DCI를 찾을 때까지 여러 번 디코딩을 반복합니다.

이 모든 과정이 Blind Decoding입니다.

Blind Decoding의 입력 정보

| 항목 | 설명 |

|---|---|

| CORESET 구성 | PDCCH가 존재할 수 있는 물리적 영역 (RB × Symbol 수) |

| Search Space 구성 | 탐색 후보 CCE 집합 정의 |

| Aggregation Level (L) | CCE 묶음 크기 (1, 2, 4, 8, 16) |

| DCI 포맷 후보 | (예: 0_0, 1_0, 1_1 등) |

| RNTI 목록 | CRC 비교용 (C-RNTI, SI-RNTI, RA-RNTI 등) |

Blind Decoding 시도 횟수 예시

만약 UE가 다음과 같은 Search Space를 모니터링한다면:

| Aggregation Level | 후보 수 (n_cand) |

|---|---|

| 1 | 6 |

| 2 | 6 |

| 4 | 4 |

| 8 | 2 |

👉 총 18개의 후보 PDCCH 를 Blind Decoding 해야 함.

(각 후보마다 CRC check 포함)

💡 단말의 디코딩 복잡도는 Search Space 구성(후보 개수, Aggregation Level 수)에 비례합니다.

CRC와 RNTI의 역할

- 모든 DCI는 전송 전 CRC 마스크(masking) 처리가 됩니다.

- 마스크용 키가 바로 RNTI (Radio Network Temporary Identifier) 입니다.

- UE는 디코딩 결과의 CRC를 각 RNTI 후보로 마스크 해제해보고, 일치하면 “이건 내 거”라고 판단합니다.

| RNTI 종류 | 용도 |

|---|---|

| C-RNTI | UE 전용 스케줄링 |

| SI-RNTI | 시스템 정보(SIB) |

| RA-RNTI | 랜덤 액세스 응답 |

| P-RNTI | 페이징 |

| TC-RNTI | 임시 연결용 |

성공 판정 조건

DCI 디코딩 후, 다음 조건을 만족해야 “성공한 Blind Decoding”입니다:

- CRC 마스크 해제 후 결과가 특정 RNTI와 일치

- DCI 포맷이 규격에 맞게 파싱 가능

- DCI 필드 내의 자원 할당 정보가 유효한 범위

Blind Decoding 복잡도 줄이기

UE는 전력 소모를 줄이기 위해 Monitoring Config 를 통해 Blind Decoding 횟수를 제한합니다.

- SearchSpaceSetConfig (RRC에서 전달): 후보 개수, aggregation level 제한

- Monitoring Slot Periodicity: 매 슬롯마다가 아니라 주기적으로 탐색

- Aggregation Level 선택적 모니터링: 약한 채널에서는 큰 L만 사용

핵심 요약

| 항목 | 설명 |

|---|---|

| 정의 | UE가 PDCCH/DCI 위치·형식을 모를 때 모든 후보를 시도적으로 디코딩 |

| 이유 | PDCCH 위치, 크기, 포맷이 가변적이기 때문 |

| 탐색 영역 | Search Space 내 후보 CCE 집합 |

| 검증 방식 | CRC + RNTI 일치 여부 |

| 복잡도 요인 | Aggregation Level, 후보 개수, DCI 포맷 수 |

| 최적화 방법 | Search Space 설정, 주기적 모니터링, UE capability 기반 제한 |

PDSCH와 PUSCH

PDSCH과 PUSCH의 기본 구조

PDSCH에는 최대 두 개의 전송 블록(Transport Block, TB) 이 존재할 수 있습니다.

반면, PUSCH에서는 하나의 체인(chain) 에 오직 하나의 전송 블록만 존재합니다.

즉, PDSCH에서는 두 개의 TB를 처리할 수 있고,

PUSCH에서는 하나만 처리됩니다.

Transport

@startuml

:Transport block (TB);

if (TBS > 3824) then (yes)

: CRC Attachment (CRC24A);

else (no)

: CRC Attachment (CRC16);

endif

if ((TBS<=292) or (TBS<=3824 and code_rate<=0.67) or (code_rate<=0.25)) then (no)

: LDCP Base Graph 1 ($$K_{cb}=8448$$);

else (yes)

: LDPC Base Graph 2 ($$K_{cb}=3840$$);

endif

if (TBS + CRC length > $$K_{cb}$$) then (no)

: No Code Block Segmentation;

: LDPC Encoding;

: Rate Matching;

else (yes)

: Code Block will be segmented;

split

: LDPC Encoding;

: Rate Matching;

split again

: ...;

: ...;

split again

: LDPC Encoding;

: Rate Matching;

split again

: ...;

: ...;

split again

: LDPC Encoding;

: Rate Matching;

end split

endif

: Code Block Concatenation;

: Scrambling;

: Modulation;

: Layer Mapping;

split

: Antenna Port Mapping;

split again

: DMRS;

split again

: PTRS;

end split

: IFFT and CP Insertation;

@enduml

CRC 부착 (CRC Attachment)

MAC 계층에서 전송 블록을 받으면, 이 TB의 크기는 매우 작을 수도, 매우 클 수도 있습니다.

TB 크기에 따라 어떤 CRC(Cyclic Redundancy Check) 를 사용할지 결정합니다.

- TB 크기 > 3824 → CRC24A 사용

- TB 크기 ≤ 3824 → CRC16 사용

CRC가 클수록 에러 검출 확률이 높기 때문에,

큰 TB에는 큰 CRC를 사용하는 것이 좋습니다.

코드 블록 분할 (Code Block Segmentation)

CRC를 부착한 후, TB를 여러 개의 코드 블록(Code Block) 으로 나눕니다.

이렇게 나누는 이유는 디코더 복잡도를 줄이기 위해서입니다.

분할 방법은 다소 복잡합니다.

먼저 LDPC Base Graph를 선택합니다.

LDPC에는 Base Graph 1과 Base Graph 2 두 가지가 있습니다.

- Base Graph 1: 큰 TB에 사용됨 (46×68 크기)

- Base Graph 2: 작은 TB에 사용됨 (42×52 크기)

이 행렬(matrix)은 LDPC 부호화 시 사용되는 패리티 체크 행렬로,

“Low Density”(즉, 1의 개수가 매우 적음) 형태입니다.

Base Graph 선택 조건:

다음 조건 중 하나라도 참이면 → Base Graph 2 사용

- TB 크기 ≤ 292 bit

- TB 크기 ≤ 3824이고, 코드율(Code Rate) ≤ 0.67

- 코드율 ≤ 1/4

그 외의 경우 → Base Graph 1 사용

Base Graph별 코드 블록 최대 크기는:

- BG1 → 8448

- BG2 → 3840

코드 블록 분할 및 CRC 부착

만약 TB+CRC의 크기가 위 코드 블록 최대 크기(Kcb)를 초과하면,

TB를 여러 개의 코드 블록으로 나눕니다.

예시:

TB+CRC = 10,000 bit, Kcb = 8448 → 2개의 코드 블록으로 나눔.

각 블록의 크기는 5000 + 24(CRC) = 5024 bit.

각 코드 블록에는 CRC24B가 추가됩니다.

분할이 없는 경우에는 이 CRC를 추가하지 않습니다.

LDPC 부호화 (LDPC Encoding)

각 코드 블록은 LDPC 부호화 모듈을 통과합니다.

LDPC 인코더의 입력 길이는 $K_b * Z_c$로 정의되며,

$Z_c$는 리프팅 사이즈(lifting size) 입니다.

BG1의 경우: Kb = 22

조건식: $22 \times Z_c >= \text{코드 블록 크기}$

예를 들어, $CB_{size} = 5024$ → 최소 Zc ≈ 240

BG2의 경우 Kb는 TB 크기에 따라 6, 8, 9, 10 중 하나가 됩니다.

입출력 크기:

- BG1 → 입력 $22{Zc}$, 출력 $66{Zc}$ (코드율 1/3)

- BG2 → 입력 $10{Zc}$, 출력 $50{Zc}$ (코드율 1/5)

부족한 비트는 Filler bits(null bits) 로 채워서

입력 크기를 맞춥니다.

Rate Matching (속도 맞춤)

LDPC 후에는 Rate Matching이 수행됩니다.

PDSCH → 항상 LBRM (Limited Buffer Rate Matching)

PUSCH → LBRM 또는 Full Buffer Rate Matching 중 선택 가능

그 후, 모든 코드 블록은 순서대로 Concatenation(연결) 되어 하나의 비트 시퀀스로 합쳐집니다.

Scrambling (스크램블링)

비트 시퀀스는 랜덤화(randomization) 되어,

다른 사용자나 셀에서의 간섭을 줄입니다.

초기화 식:

- PDSCH: $n_{RNTI} * 2^{15} + 9*2^{14} * \text{(codeword index)} + n_{ID}$

- PUSCH: $n_{RNTI} * 2^{15} + n_{ID}$

UCI(User Control Information) 비트는 별도의 스크램블링을 사용합니다.

Modulation (변조)

- PDSCH → QPSK, 16QAM, 64QAM, 256QAM

- PUSCH → 위 4가지 + (Transform Precoding 활성화 시) π/2 BPSK

Layer Mapping (계층 매핑)

- PDSCH: 최대 8개 레이어

- PUSCH: 최대 4개 레이어

각 코드워드(codeword)는 독립적으로 레이어에 매핑됩니다.

레이어 수에 따라 심볼이 번갈아가며 배치됩니다.

(예: 2레이어일 때 L0 → 짝수, L1 → 홀수 심볼)

안테나 포트 매핑 및 자원 블록 매핑

이 부분은 매우 복잡하므로, 별도의 영상에서 다룬다고 합니다.

(DMRS와 연관됨)

Reception

@startuml

:CP Removal and FFT;

: REsource Block De-mapping;

split

: DMRS Channel Estimation;

split again

: PTRS Channel Estimation;

end split

: Equalizer;

: Layer De-mapping;

: Soft De-modulation;

: De-scrambling;

split

if ((TBS<=292) or (TBS<=3824 and code_rate<=0.67) or (code_rate<=0.25)) then (no)

: LDPC Base Graph 1 ($$K_{cb}=8448$$);

else (yes)

: LDCP Base Graph 2 ($$K_{cb}=3840$$);

endif

split again

end split

if (TBS+CRC length > $$K_{cb}$$) then (no)

: No Code Block Segmentation;

: Rate De-Matching;

: LDPC Decoding;

else (yes)

: Code Block will be segmented;

split

: Rate De-Matching;

: LDPC Decoding;

split again

: ...;

: ...;

split again

: Rate De-Matching;

: LDPC Decoding;

split again

: ...;

: ...;

split again

: Rate De-Matching;

: LDPC Decoding;

end split

endif

: Code Block Concatenation;

: CRC Removal;

: Transpot Block (TB);

@enduml

수신단 처리 (Receiver Processing)

수신단은 송신단의 반대 순서로 동작합니다.

- DMRS 복조 후 채널 추정

- Equalizer (ZF, MMSE 등) 적용

- Layer De-mapping

- Soft Demodulation (LLR 값 생성)

- Descrambling

- Code Block Segmentation 복원

- Rate Dematching

- LDPC 디코딩

- Code Block 재조합 및 CRC 검사

마지막으로 CRC24A를 제거하면 최종 Transport Block 이 복원됩니다.

Transport Block Size Calculation

개요 — TBS란 무엇인가?

TBS (Transport Block Size) 는 한 번의 PDSCH (Downlink) 또는 PUSCH (Uplink) 전송에서 물리계층(PHY)이 상위계층(MAC)으로부터 받아 처리할 수 있는 데이터 비트의 양을 의미합니다.

즉,

“한 번 전송에 실릴 수 있는 payload 크기(비트 단위)”입니다.

TBS 계산의 주요 입력 변수

TBS는 아래 값들에 의해 결정됩니다 👇

| 항목 | 의미 | 단위 | 설명 |

|---|---|---|---|

| \(N_{PRB}\) | 할당된 Physical Resource Block 개수 | 개 | 주파수 자원 폭 |

| \(N_{symb}\) | 사용된 OFDM symbol 개수 | 개 | 시간 자원 길이 |

| \(N_{sc}\) | 서브캐리어 개수 (12) | 개 | PRB당 subcarrier 수 |

| \(N_{RE}^{used}\) | 실제 데이터용 RE 개수 | 개 | DMRS, CSI-RS 등 제외한 RE 수 |

| \(Q_m\) | 변조 차수 (Modulation Order) | bit/sym | QPSK=2, 16QAM=4, 64QAM=6, 256QAM=8 |

| R | 코드율 (Coding Rate) | - | LDPC / Polar 부호율 |

| \(N_{layer}\) | 계층(layer) 수 | 개 | MIMO 전송 시 병렬 스트림 수 |

| \(N_{OH}\) | 오버헤드 비트 | - | (예: UCI 포함 시 6 등) |

기본 개념 공식

우선, 전송 가능한 총 비트 수의 근사값은 다음과 같습니다 👇 \(N_{info} = N_{PRB} × N_{sc} × N_{symb} × Q_m × R × N_{layer}\) 하지만 실제 표준(3GPP 38.214 / 38.212)에서는 비트 단위 rounding, segmentation, lookup table 등을 포함해 아래 절차로 계산합니다.

TBS Calculation Step-by-Step (3GPP TS 38.214 §5.1.3.2)

Step 1️: 유효 RE 계산

- $N_{RE}^{PRB} = N_{sc}^{PRB} × N_{symb}^{slot} - N_{DMRS}^{PRB} - N_{OH}$

- $N_{sc}^{PRB} = 12$

- $N_{symb}^{slot} \text{ = 실제 데이터 심볼 개수 (보통 14 - DMRS 심볼 수)}$

- $N_{DMRS}^{PRB} \text{ = DMRS가 차지하는 RE 수}$

- $N_{OH} \text{ = 기타 오버헤드 (기본적으로 0, 경우에 따라 6)}$

Step 2️: 전체 자원 RE 계산

\(N_{RE}^{total} = N_{PRB} × N_{RE}^{PRB}\)

Step 3️: 초기 비트수 계산

\[N_{info}^{init} = N_{RE}^{total} × Q_m × R\]Step 4️: 3GPP 표준 TBS Table 적용

실제 TBS는 위 단순 계산값을 직접 쓰지 않고,

3GPP에서 정의된 TBS lookup table 에 따라 정규화(rounding)합니다.

- 작은 전송 (≤ 3824 bits):

→ 직접 계산식 적용 (integer rounding) - 큰 전송 (> 3824 bits):

→ 아래 표준화된 “TBS table index”를 기반으로 근사값 선택

즉, 다음 절차를 따릅니다:

\[N_{info}^{’} = \text{TBS\_table}(N_{info}^{init})\]Step 5️: 계층 수 반영

\(TBS = N_{info}^{’} × N_{layer}\)

실제 예시 (Downlink PDSCH)

| 파라미터 | 값 | 설명 |

|---|---|---|

| \(N_{PRB}\) | 50 | 10 MHz 대역에서 약 50 PRB |

| \(N_{symb}\) | 12 | 슬롯당 14심볼 중 2개는 DMRS로 사용 |

| \(Q_m\) | 6 | 64QAM |

| \(R\) | 0.5 | 코드율 1/2 |

| \(N_{layer}\) | 2 | MIMO 2×2 |

| \(N_{RE}^{PRB}\) | 12×12 - DMRS(12) = 132 |

계산:

\(N_{RE}^{total} = 50 × 132 = 6600\)

\(N_{info} = 6600 × 6 × 0.5 × 2 = 39600 \text{ bits}\)

즉,

한 슬롯(1 ms)당 약 39.6 kb 데이터 전송이 가능.

LTE와 NR의 차이점

| 항목 | LTE | 5G NR |

|---|---|---|

| Modulation | 최대 64QAM | 최대 256QAM |

| Code rate | 고정 표준 범위 (≈ 0.93) | 유연한 LDPC rate |

| Table 방식 | 고정 테이블 기반 | 2가지 TBS Table (normal, high SE) |

| Multiple layers | 최대 4 | 최대 8 |

5G NR에서는 “TBS Table 1” (normal) 과 “TBS Table 2” (high spectral efficiency) 두 종류를 선택 가능합니다.

TBS Table 개요 (3GPP 38.214, Table 5.1.3.2-1)

| Index | NinfoN_{info}Ninfo (bit) | Index | NinfoN_{info}Ninfo (bit) |

|---|---|---|---|

| 0 | 24 | 9 | 328 |

| 10 | 408 | 20 | 1560 |

| 30 | 5048 | 40 | 20000 |

| 50 | 40832 | 60 | 119192 |

| 75 | 382400 | … | … |

즉, 실제 시스템에서는 연속적인 계산값을 이 테이블에 매핑하여 사용합니다.

PUSCH의 경우 (Uplink)

PUSCH도 기본적으로 같은 계산 로직을 따릅니다.

단, 추가 고려 항목이 있습니다:

| 항목 | 설명 |

|---|---|

| UCI (Uplink Control Information) | HARQ-ACK, CSI 보고 등 제어 비트 포함 시 오버헤드 발생 |

| DMRS Pattern | Uplink은 Type1/Type2 패턴 선택에 따라 DMRS RE 수 다름 |

| Code Rate | PUSCH에서는 실제 유효 코드율이 더 낮음 |

| Transform Precoding (DFT-s-OFDM) | Release 15에서는 optional, RE 매핑 방식 다름 |

따라서 PUSCH에서는 오버헤드(OH) 항이 더 크게 반영됩니다.

핵심 요약

| 항목 | 의미 | 설명 |

|---|---|---|

| TBS | Transport Block Size | 한 전송에서 전송 가능한 비트 수 |

| 적용 채널 | PDSCH / PUSCH | Downlink / Uplink 데이터 채널 |

| 기준 요소 | PRB, Symbol 수, Modulation, Code Rate, Layers | |

| 계산식(근사) | \(TBS ≈ N_{PRB} × N_{symb} × 12 × Q_m × R × N_{layer}\) | |

| 표준 규격 | 3GPP TS 38.214 §5.1.3.2, §6.1.4 |

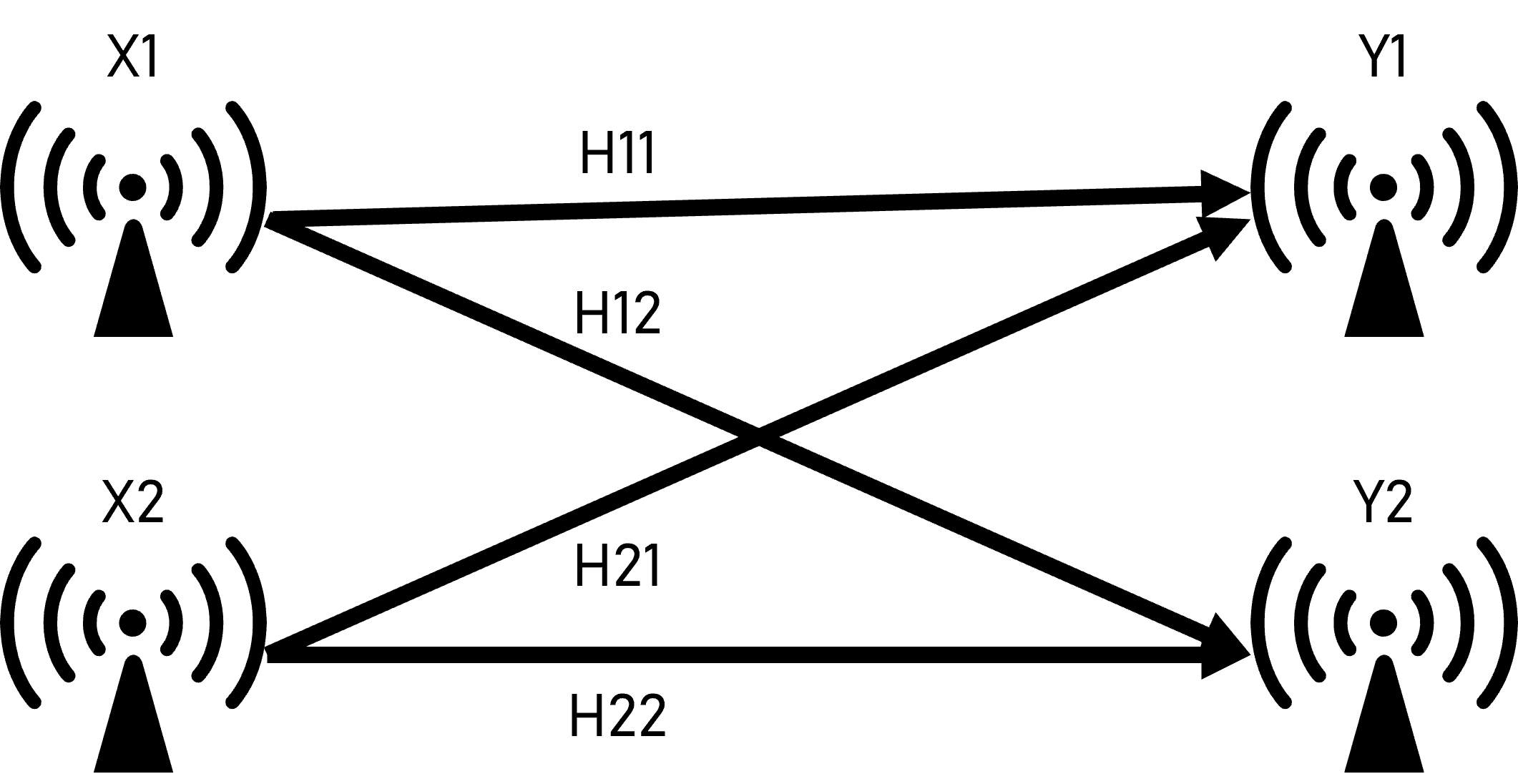

Precoding for MIMO

기본 개념

Precoding 이란,

여러 송신 안테나를 이용할 때 데이터 스트림을 안테나 신호로 변환하기 위한 행렬 연산입니다.

즉,

“기지국이 여러 안테나를 통해 데이터를 어떻게 섞어서(phase + amplitude control) 송신할 것인가?”를 결정하는 과정이에요.

수식으로 표현하면 👇

\(\mathbf{x} = \mathbf{W} , \mathbf{s}\)

| 기호 | 의미 |

|---|---|

| s | 데이터 스트림 벡터 $(N_layer × 1)$ |

| W | Precoding Matrix $(N_TX × N_layer)$ |

| x | 송신 안테나별 신호 벡터 $(N_TX × 1)$ |

Precoding의 목적

| 목적 | 설명 |

|---|---|

| 1. Beamforming | 여러 안테나의 위상/진폭을 조합해 원하는 방향으로 전력 집중 |

| 2. Interference Suppression | 다중 UE 간 간섭 최소화 |

| 3. Spatial Multiplexing | 병렬 스트림 전송으로 전송량(throughput) 극대화 |

| 4. Diversity Gain | 전파 페이딩에 강한 송신 신호 구성 |

MIMO 전송 구조

단순화된 블록도

+-------------------+

Data --> | Layer Mapper | --> s₁,s₂,…

+-------------------+

│

▼

+-------------------+

| Precoder (W) | --> x₁,…,xₙ (N_TX 안테나)

+-------------------+

│

Radio Tx → 채널 → 수신기

- Layer Mapper: 전송 계층 수 $(N_{layer})$ 결정

- Precoder: 각 스트림을 안테나 신호로 변환

- Channel Matrix H: 무선 경로

- Receiver: 수신 Combining / Equalization 수행

MIMO 전송 모드와 Precoding

| 전송 모드 | 특징 | Precoding 전략 |

|---|---|---|

| Transmit Diversity | 여러 안테나로 같은 데이터 전송 | 고정 precoding (예: Alamouti) |

| Spatial Multiplexing | 서로 다른 데이터 스트림 병렬 전송 | 동적 precoding (채널 피드백 필요) |

| Beamforming | 동일 데이터를 특정 방향으로 집중 | 단일 precoding 벡터 (Rank 1) |

| MU-MIMO | 여러 UE 동시 서비스 | 각 UE 별 precoder로 간섭 억제 |

| SU-MIMO | 단일 UE에 복수 스트림 | 동일 precoder 행렬 공유 |

Precoding Matrix (수학적 형태)

\[\mathbf{W} = \begin{bmatrix} w_{11} & w_{12} & \cdots & w_{1L} \\ w_{21} & w_{22} & \cdots & w_{2L} \\ \vdots & \vdots & \ddots & \vdots \\ w_{N_T1} & w_{N_T2} & \cdots & w_{N_TL} \end{bmatrix}\]- $(N_T)$: 송신 안테나 수

- (L): Layer 수

- 각 열은 한 Layer의 빔 형태를 나타냄.

- 각 행은 송신 안테나 별 가중치(weight).

Precoding Matrix Index (PMI)

- 실제 5G 시스템에서 precoding 행렬 자체를 보내지 않고,

단말(UE)은 PMI (Precoding Matrix Indicator) 라는 인덱스만 피드백합니다. - gNB는 그 인덱스에 해당하는 행렬을 표준 Lookup Table (PMI Codebook)에서 선택해 사용합니다.

| 피드백 항목 | 의미 |

|---|---|

| RI (Rank Indicator) | Layer 수 |

| PMI | Precoding Matrix Index |

| CQI | Channel Quality Indicator (MCS 결정용) |

Precoding 전략의 구분

| 구분 | 설명 |

|---|---|

| Codebook-based Precoding | UE가 표준 코드북 내 행렬 중 하나를 선택(PMI 보고) → gNB 적용 |

| Non-codebook Precoding | gNB가 직접 채널 정보를 추정하고 가중치 계산 (예: Massive MIMO) |

| Hybrid Beamforming | 아날로그(phase shifter) + 디지털(baseband) precoding 조합 |

Massive MIMO Precoding 예시

-

gNB 안테나 수 ≫ Layer 수

-

Hybrid precoding 사용:

\(\mathbf{W} = \mathbf{W}_{RF} \times \mathbf{W}_{BB}\)- $( \mathbf{W}_{RF} )$: Analog beamforming (phase control)

- $( \mathbf{W}_{BB} )$: Digital baseband precoding

이 방식으로 수십 개의 빔을 동시에 형성하면서,

특정 UE 방향으로 에너지를 집중시킬 수 있어요.

수신단(UE)에서의 Combining

UE는 수신 신호를 역방향 으로 Combining Matrix (V) 를 이용해 처리합니다.

\[\hat{\mathbf{s}} = \mathbf{V}^{H} \mathbf{y}\]- 송신단 precoding $( \mathbf{W} )$

- 수신단 combining $( \mathbf{V} )$

→ 결국 채널 행렬 $( \mathbf{H} )$ 와 곱해져

$( \mathbf{V}^H \mathbf{H} \mathbf{W} )$ 의 대각화가 이상적 목표입니다.

핵심 요약

| 항목 | 설명 | | ——— | —————————————————– | | 정의 | MIMO에서 데이터 스트림을 송신 안테나 신호로 변환하기 위한 가중 행렬 | | 수식 | $\mathbf{x} = \mathbf{W} \mathbf{s}$ | | 입력 | Layer 데이터 벡터 s | | 출력 | 송신 안테나 신호 x | | 종류 | Beamforming, Spatial Multiplexing, Diversity, MU-MIMO | | 제어정보 | PMI, RI, CQI | | 표준 문서 | 3GPP TS 38.211 §7.3, 38.214 §6.3.1 |

추가: 수식의 이해

\(\begin{align} Y_1&=H_{11}\cdot X_1+\omega_1+H_{21}\cdot X_2+\omega_2 \\ Y_2&=H_{12}\cdot X_1+\omega_1+H_{22}\cdot X_2+\omega_2 \\ \binom{Y_1}{Y_2}&=\begin{pmatrix}H_{11}&H_{21}\\H_{12}&H_{22}\\\end{pmatrix}\cdot\binom{X_1}{X_2}+\binom{\omega_1}{\omega_2} \\ Y &= H \cdot X + \omega \end{align}\) 여기에서 H는 채널 상태 변수이고 $\omega$는 잡음입니다. H 행렬은 송신된 신호가 수신기에서 어떻게 변화하는지를 나타내며, 각 송신 안테나와 수신 안테나 쌍에 대해 위상과 진폭을 표시하는 요소들로 구성됩니다. 상태 변수는 매우 빠른 시간에 자주 변경됩니다.

PRACH (Physical Random Access Channel)

PRACH(물리 랜덤 액세스 채널)은 UE가 gNB에 처음 접속할 때, 혹은 핸드오버/재접속 시 랜덤 액세스(RA) 절차를 시작하기 위한 물리 계층 채널입니다.

UE는 PRACH를 사용해 Preamble(프리앰블)을 전송하여 gNB가 UE의 존재를 알고, UL 동기화, 빔 선택, 자원 할당을 할 수 있게 됩니다.

PRACH의 주요 목적

1) 초기 접속(Initial Access)

UE가 처음 셀에 붙을 때 PRACH Preamble(MSG1)을 보냅니다.

gNB는 MSG2(RAR)로 Timing Advance와 UL Grant를 주어 UL 동기화가 이루어집니다.

2) 빔 관리(Beam Management)

특히 mmWave(FR2)에서 매우 중요합니다.

SSB 빔 방향을 기준으로 UE는 해당 SSB에 대응하는 PRACH 자원(RO)을 선택해 전송합니다.

3) 핸드오버 및 재접속(RRC Re-establishment)

HO-RACH 또는 재접속 시 동일한 RA 절차를 다시 수행합니다.

NR PRACH Preamble 종류

NR은 두 가지 계열의 Preamble을 사용합니다.

장형(LRA, Long Preamble)

- 839포인트 Zadoff–Chu 기반

- 긴 CP → 대형 셀(매크로, Rural) 용

- LTE와 유사하지만 NR은 훨씬 더 유연한 설정 가능

단형(SRA, Short Preamble)

- 짧은 DFT-s-OFDM 기반

- 하나의 슬롯에 여러 개의 Preamble 배치 가능

- TDD, FR2(mmWave), Urban Small Cell 환경에 최적화

NR은 LTE보다 Preamble 종류·길이·자원 배치가 훨씬 더 다양합니다.

FR1 vs FR2 환경에서의 PRACH

| 구분 | 주파수 | 특징 | Preamble 유형 |

|---|---|---|---|

| FR1 | 6GHz 이하 | 일반 LTE와 유사한 환경 | 장형 + 단형 |

| FR2 | 24~52GHz | 빔포밍 필수, Path Loss 큼 | 단형만 사용 |

특히 FR2에서는 SSB 빔 스위핑 + PRACH 빔 기반 RA가 핵심입니다.

NR Random Access 4-단계 절차

NR은 기본적으로 4-Step RA 절차를 사용합니다.

Msg1: PRACH Preamble 전송

- UE가 RO(Random Access Occasion)에서 Preamble 선택 후 송신

- gNB는 Timing Advance 측정

Msg2: Random Access Response (RAR)

- TA(UL Timing Advance)

- UL Grant

- Temporary C-RNTI 주소가 포함됨

Msg3: RRC 계층 메시지 전송

- UL Grant로 UL-SCH(PUSCH) 통해 UE ID 등 전송

Msg4: Contention Resolution

- gNB가 충돌 해결

- UE는 자신의 ID가 포함된 메시지를 확인하면 액세스 성공

NR은 필요에 따라 2-Step RA도 지원하지만, 대부분의 셀에서는 여전히 4-Step을 사용합니다.

빔포밍 기반 PRACH(Beam-based PRACH)

5G NR의 핵심 차별점은 바로 빔 기반 PRACH입니다.

- gNB는 SSB를 여러 빔 방향으로 송출(Beam sweeping)

- UE는 가장 강한 SSB Beam 선택

- 그 SSB와 매핑된 PRACH 자원에 Msg1을 송신

- gNB도 빔 기반으로 Msg2/Msg4 응답

→ FR2(mmWave)에서 접속 성공률을 끌어올리는 핵심 기술

PRACH 주요 RRC 파라미터 (TS 38.331)

gNB는 RRC 메시지로 PRACH 자원을 설정합니다. 핵심 파라미터:

prach-ConfigurationIndexrach-ConfigCommon/rach-ConfigDedicatedmsg1-FDM(1~8개의 주파수 도메인 레이어)zeroCorrelationZoneConfigssb-perRACH-OccasionAndCB-PreamblesPerSSBra-ResponseWindow

NR은 CBRA(SI 기반)와 CFRA(UE별 전용 RA 자원) 모두 지원합니다.

LTE 대비 NR PRACH 차이점

| 항목 | LTE | NR |

|---|---|---|

| Preamble 타입 | 긴 ZC 기반만 | 장형+단형, 매우 유연 |

| 빔포밍 | 거의 없음 | 필수 (특히 FR2) |

| FDM 자원 | 제한적 | Msg1-FDM으로 최대 8개 FDM 가능 |

| FR2 지원 | X | O |

| SSB 매핑 | 없음 | SSB 기반 RO 매핑 필수 |

NR PRACH는 빔포밍·FR2·스몰셀 환경에 맞춰 대폭 확장된 구조입니다.

참고할 3GPP TS 문서

- 38.211 – 물리 채널 및 변조(→ PRACH 형식 정의)

- 38.212 – 채널 코딩/멀티플렉싱

- 38.213 – 물리 레이어 절차(→ RA Flow)

- 38.331 – RRC 규격(PRACH 설정 포함)

PRACH 포맷 A1 / A2 / B1 / B2 / C0 / C2 비교표

(3GPP TS 38.211 기반 요약)

5G NR PRACH는 Short Sequence 계열(SRA)에서 A/B/C 시리즈를 사용합니다.

이는 슬롯 내 자원 배치, CP 길이, 서브캐리어 간격, 반복 횟수가 다릅니다.

NR Short PRACH Format 비교표

| 포맷 | 특징 | Subcarrier spacing | 기저 OFDM 심볼 수 | 반복(Repetition) | 적용 환경 |

|---|---|---|---|---|---|

| A1 | 가장 짧은 PRACH 포맷 중 하나 | 15 kHz | 1 | 4 | 소형 셀, FR1 |

| A2 | A1보다 반복 적음 | 30 kHz | 1 | 2 | TDD/Urban |

| B1 | CP 길이 증가 | 15 kHz | 2 | 4 | 중간 셀 |

| B2 | B1의 30 kHz 버전 | 30 kHz | 2 | 2 | TDD, 빔기반 |

| C0 | 더 넓은 BW, 짧은 길이 | 60 kHz | 1 | 1 | FR2 mmWave |

| C2 | C0보다 CP 더 짧음 | 120 kHz | 1 | 1 | FR2 mmWave |

📌 핵심 요약

- A/B 시리즈 = 주로 FR1

- C 시리즈 = FR2 전용

- SCS가 커질수록 세그먼트 길이 ↓, 빔 기반 RA에 최적화

- 반복(Repetition)은 Coverage 보완용

RA 4-Step 프로시저 시퀀스 다이어그램

아래는 3GPP NR RA 절차 전체입니다.

@startuml

title 5G NR Random Access 4-Step Procedure

UE -> gNB: Msg1: PRACH Preamble (RA-RNTI)

gNB -> UE: Msg2: RAR (Timing Advance, UL Grant, Temp C-RNTI)

UE -> gNB: Msg3: RRC or MAC CE message\n(using UL-SCH with UL Grant)

gNB -> UE: Msg4: Contention Resolution\n(contains UE identity)

@enduml

📌 설명 요약

- Msg1: UE가 RO에서 PRACH 전송

- Msg2: TA + UL Grant + Temporary C-RNTI

- Msg3: UL-SCH로 ID/RRC 메시지 전송

- Msg4: UE-Identifier 포함 → 충돌 해결

FR2 SSB – PRACH 매핑 구조 그림 (텍스트 기반 구조도)

FR2(mmWave)는 SSB Beam sweeping과 PRACH Beam 매핑이 필수입니다.

gNB:

┌─────────────────────────────────────────┐

│ SSB Beam 1 → PRACH Occasion #1 │

│ SSB Beam 2 → PRACH Occasion #2 │

│ SSB Beam 3 → PRACH Occasion #3 │

│ ... │

│ SSB Beam N → PRACH Occasion #N │

└─────────────────────────────────────────┘

UE:

1) 모든 SSB 신호 수신 후 RSRP 측정

2) 가장 강한 SSB Beam 선택

3) 해당 SSB에 대응하는 PRACH RO에서 Preamble 전송

📌 핵심 메커니즘

- FR2는 빔 방향성을 반드시 사용해야 함

- 각 SSB는 특정 RACH Occasion과 매핑

- Msg2/Msg4도 동일 빔으로 답신해야 RA 성공률이 높음

RACH 디버깅 로그 해석

(실제 L2/L1 로거 기반 정리)

Msg1 (PRACH 전송 로그)

- TX Time / RO index

- Preamble Index

- SSB index와의 매핑

- TX power, TA estimate

예시 로그 해석:

PRACH: RO=5, PreambleID=23, SSB=7, Power=18 dBm

→ UE가 SSB#7 기반으로 RO#5에서 23번 preamble을 전송한 상황

Msg2 (RAR 수신 로그)

RAR 내용:

TimingAdvanceUL Grant(RB start, size, MCS)Temporary C-RNTI

예시:

RAR: TA=36, ULGrant:RB(12,4), TempCRNTI=0x1234

Msg3 전송 로그

- PUSCH으로 UL message 송신

- UL Grant 기반 RB/MCS 확인 필요

예시:

Msg3: UL-SCH Tx, T-CRNTI=0x1234, RB=12-16, MCS=4

Msg4 (Contention Resolution)

Msg4에 UE ID가 포함되면 성공

예시:

CR: MAC CE UE-ID Match

RACH 실패 원인 분석 (전문가용)

5G NR RACH 실패는 크게 동기화 / 빔 / 자원 / HARQ / 전력 실패로 나뉩니다.

1) Beam Mismatch (FR2에서 매우 흔함)

원인

- UE가 SSB#7에서 PRACH 보냈는데

- gNB가 Msg2를 다른 빔으로 송신함

증상

- Msg1 OK → Msg2 미수신

- RAR timeout

해결

- Beam correspondence 개선

- SSB–PRACH 매핑 재설정

2) RO (Random Access Occasion) mismatch

원인

- UE가 잘못된 시간/주파수의 PRACH RO 사용

- RRC-config 오해석 또는 gNB misalignment

증상

- Msg1 detection 실패

- UE는 연속적으로 재시도(Msg1 반복)

3) Timing Advance 실패

원인

- gNB가 TA를 너무 작게/크게 보냄

- UE의 MSG3가 UL 영역 밖으로 벗어남

증상

- gNB가 Msg3 디코딩 실패

- Msg4 없음 → Contention timeout

4) 전력 부족 (Power Limited UE)

원인

- UE가 PRACH Power ramp-up 한계 도달

- FR2에서 특히 발생

증상

- Msg1 미검출

- PRACH MaxPower error

5) Collision (Contention)

원인

- 두 UE가 동일 Preamble 사용

증상

- Msg2 수신 OK

- Msg3 충돌 → Msg4에서 UE-ID mismatch

6) UL Grant 문제

원인

- RAR의 UL Grant 자원이 PUSCH 구성과 충돌

- 주파수 경계 문제

증상

- Msg3 디코딩 실패

PRACH 모든 포맷 (A/B/C 시리즈) 전체 테이블

5G NR PRACH 포맷은 크게:

- Long sequence:

0, 1, 2, 3(LTE 계열, L_RA = 839, 대형 셀, FR1) (NXG Connect) - Short sequence:

A1, A2, A3, B1, B2, B3, B4, C0, C2(L_RA = 139, 소형/빔기반/FR2 포함) (NXG Connect)

여기서는 요청하신 A/B/C 시리즈만 요약합니다. (정확한 샘플 길이·심볼 수는 38.211 Table 6.3.3.1-2 참고.)

⚠️ 아래 SCS/용도는 대표적인 매핑 기준이며, 실제 지원 조합은

prach-ConfigurationIndex에 따라 달라질 수 있습니다. (mathworks.com)

| 포맷 | 시퀀스 길이 L_RA | 대표 SCS (Δf_RA) | 구조(심볼/반복) 개념 | 특징/용도 (대표) |

|---|---|---|---|---|

| A1 | 139 | 15 kHz | 짧은 preamble 1개 + 반복 다수 | FR1, 소형/노멀 셀, 커버리지↑ |

| A2 | 139 | 30 kHz | A1보다 짧은 반복 | TDD, 약간 더 좁은 커버리지, 짧은 TTI |

| A3 | 139 | 60 kHz | 더 짧은 길이, 고 SCS | 레이턴시 민감, 고속/밀집 환경 |

| B1 | 139 | 15 kHz | 2 심볼 구조 + 반복 | 중간 크기 셀, 다소 큰 지연 스프레드 대응 |

| B2 | 139 | 30 kHz | B1의 30kHz 버전 | TDD Urban, 빔 기반 RA 용이 |

| B3 | 139 | 60 kHz | B2보다 더 짧은 TTI | 고밀도, 고속 핸드오버 |

| B4 | 139 | 120 kHz | 초고 SCS, 짧은 preamble | FR2 edge 용도로도 사용 가능 |

| C0 | 139 | 60 kHz | 단일 짧은 preamble | FR2 mmWave 대표 포맷 |

| C2 | 139 | 120 kHz | C0보다 더 짧은 유효 길이 | 빔포밍 전제 초근거리/초소형 셀 |

핵심 정리:

- A 시리즈: 짧고 반복 위주, 소형/일반 셀

- B 시리즈: 2심볼 구조, 지연 스프레드 조금 더 커버

- C 시리즈: FR2 중심, 초고 SCS, 빔 기반 mmWave RA에 최적화

FR2 빔 기반 RA 상세 구조

(1) 개념 구조 (ASCII 다이어그램)

[Downlink 방향]

gNB

├─ SSB Beam #0 ──► UE (측정)

├─ SSB Beam #1 ──► UE (측정)

├─ SSB Beam #2 ──► UE (측정)

└─ ...

UE

├─ 모든 SSB RSRP/RSRQ 측정

├─ Best Beam = SSB #k 선택

└─ "SSB #k ↔ PRACH RO(#k)" 매핑 테이블 사용

[Uplink 방향]

UE

└─ SSB #k에 대응되는

PRACH Occasion(시간/주파수/빔)에서

Short PRACH (예: C0/C2) 전송 (Msg1)

gNB

├─ 동일 Beam #k Rx 빔포밍으로 PRACH 검출

├─ Timing Advance, Power, Beam ID 추출

└─ 같은 Beam #k로 Msg2/Msg4 전송

포인트:

- “SSB index ↔ RACH Occasion ↔ Beam index” 매핑이 FR2 RA의 핵심

- Beam이 틀리면 (=beam mismatch) Msg2가 안 들어와서 RA 실패 확률 급상승

(2) 빔 기반 RA 시퀀스

@startuml

title FR2 Beam-based 5G NR RACH

actor UE

participant "gNB (Beam #0..N)" as gNB

== Downlink Beam Sweeping ==

gNB -> UE: SSB Beam #0..N 전송\n(SSB index, beamforming)

UE -> UE: 각 SSB RSRP 측정\nBest SSB index k 선택

== Uplink Beam-based PRACH ==

UE -> gNB: Msg1: PRACH Preamble\n(on PRACH RO mapped to SSB#k, Beam#k)

gNB -> gNB: Beam#k 방향 Rx 빔포밍\nPreamble 검출, TA 추정

gNB -> UE: Msg2: RAR\n(동일 Beam#k, TA + UL Grant + TempC-RNTI)

UE -> gNB: Msg3: UL-SCH(PUSCH)\n(Beam#k 기반 UL 빔포밍)

gNB -> UE: Msg4: Contention Resolution\n(Beam#k, UE-ID 포함)

@enduml

RACH 성공률 분석 메트릭 (factory log 스타일)

운영/팩토리 환경에서 RACH 품질 지표(KPI)를 설계할 때 자주 쓰는 방식입니다.

(1) 기본 지표 정의

- RACH_Attempt

- RA 프로시저 시작 시도 수 (Msg1 전송 기준 카운트)

- RACH_Detected_Msg1

- gNB가 PRACH preamble을 검출한 수

- RACH_RAR_Success

- UE가 유효한 RAR(Msg2)을 수신한 수

- RACH_Msg3_Success

- gNB가 Msg3 PUSCH를 정상 디코딩한 건수

- RACH_CR_Success (Full Success)

- Msg4 Contention Resolution까지 끝난 “완전히 성공한 RA” 수

(2) KPI 예시 수식

- Preamble Detection Rate

\(P_{det} = \frac{RACH\_Deetected\_Msg1}{RACH\_{Attempt}}\) - RAR Success Rate

\(P_{RAR} = \frac{RACH\_RAR\_Success}{RACH\_Detected\_Msg1}\) - Msg3 Decode Success Rate

\(P_{M3} = \frac{RACH\_Msg3\_Success}{RACH\_RAR\_Success}\) - End-to-End RA Success Rate

\(P_{RA} = \frac{RACH\_CR\_Success}{RACH\_Attempt}\)

추가로, 아래처럼 Slice / Beam / Format 별로 쪼개서 보는 게 실제 팩토리에서 많이 씁니다:

RACH_SuccessRate[format=A1/A2/…]RACH_SuccessRate[beamIndex]RACH_SuccessRate[FR1 vs FR2]RACH_SuccessRate[CBRA vs CFRA]

(3) 예시 “공장 로그” 스타일 요약 테이블

Day, Cell, FR, Format, Beam, Attempts, CR_Success, RA_SuccessRate

2025-11-14, Cell01, FR1, A1, -, 10500, 10290, 98.0%

2025-11-14, Cell01, FR2, C0, B7, 8000, 7200, 90.0%

2025-11-14, Cell01, FR2, C2, B3, 4000, 3200, 80.0%

...

이렇게 보면:

- 특정 Beam(C2, B3)에서만 RA 성공률이 떨어지는지

- 특정 포맷(C2)에서만 떨어지는지

직관적으로 잡을 수 있습니다.

실제 gNB/UE 로그 예제 기반 디버깅 튜토리얼

완전 단순화한 예제 로그를 하나 만들어서, 실패 원인을 추적하는 과정을 보여드리겠습니다.

(1) 시나리오: FR2, C0 포맷, Beam mismatch 의심 케이스

gNB PRACH 검출 로그

[GNODEB][RACH] DETECT: Cell=1, SSB=7, Beam=7,

PreambleID=23, TA=32, RxPwr=-92 dBm

→ gNB는 SSB#7 / Beam7 방향에서 Preamble 23 검출

gNB RAR 송신 로그

[GNODEB][RAR] TX: Cell=1, Beam=5, // (주의) Beam5로 Tx

RA-RNTI=0x12C3, TempC-RNTI=0x1234,

TA=32, ULGrant=RB(24,6), MCS=4

→ 설정상은 Beam7 방향으로 보내야 하는데 구현/설정 문제로 Beam5로 나가는 버그

UE 로그

[UE][RACH] Msg1: Sent, SSB=7, RO=15, PreambleID=23

[UE][RACH] Waiting for RAR (Window=3 slots)...

[UE][RACH] RAR timeout, no valid RAR detected

[UE][RACH] Backoff 20ms, reattempt count=1

→ UE는 빔 #7 방향만 모니터링하는데, gNB가 빔 #5로 RAR을 보내니까 RAR을 못 봄 → Timeout

디버깅 포인트

- gNB 측:

- SSB index ↔ Beam index ↔ RACH Occasion ↔ RAR Beam index 매핑 테이블 확인

- 빔 인덱스 오프셋/버그 여부 확인

- UE 측:

- 다른 빔도 모니터링하도록 설계할 것인지(벤더 구현 choice)

(2) 시나리오: Msg3 디코딩 실패 (TA 문제)

[GNODEB][RACH] DETECT: PreambleID=11, TA=12

[GNODEB][RAR] TX: TA=12, ULGrant=RB(30,4)

[UE][RACH] Rx RAR OK, apply TA=12

[UE][PUSCH] Msg3 TX: using TA=12

[GNODEB][PUSCH] Msg3 CRC FAIL (TA error suspected)

[UE][RACH] No Contention Resolution, RA fail, reattempt

- 서브프레임/슬롯 레벨에서 TA가 실제 채널과 mismatch → Msg3 UL 심볼이 경계에서 엇나가 PUSCH 디코딩 실패

- 이런 경우엔:

- TA 추정 알고리즘 (L1) 확인

- multi-path delay spread 환경에서의 PRACH 포맷 선택 재검토 (다른 포맷 B1/B2 등)

RA 시퀀스 타이밍 다이어그램 (슬롯/심볼 단위)

(1) FR1 예: μ = 1 (30 kHz), 14심볼/슬롯 기준

아주 단순화한 텍스트 타이밍입니다.

시간 축 (슬롯 단위, DL/UL mixed TDD 가정)

Slot n

├─ DL: SSB 송신 (심볼 0~3)

├─ DL: PDCCH/PDSCH

└─ UL: 공백 또는 다른 UL

Slot n+1

├─ UL: PRACH RO 위치 (예: 심볼 2~3)

│ → Msg1: PRACH Preamble 전송

└─ 나머지 UL 자원 비워두거나 PUSCH

Slot n+2 ~ n+K

├─ DL: RAR Window

│ → gNB가 이 기간 중 PDCCH+PDSCH로 Msg2(RAR) 송신

│ (RA-RNTI 기반 검색)

└─ UE: RAR 수신 대기

Slot n+L

├─ UL: UL Grant (RAR에 있던 RB/MCS) 기반

│ → Msg3: PUSCH 전송

└─ DL: 다른 트래픽

Slot n+M

├─ DL: Msg4 (CR) 포함 PDCCH+PDSCH

│ → UE ID 매칭되면 RACH 성공

└─ 이후: 정상 RRC 절차 진행

핵심 파라미터:

- PRACH Occasions:

prach-ConfigurationIndex에 의해 특정 슬롯/심볼에 매핑 - RAR Window:

ra-ResponseWindow(예: 3, 5, 10 슬롯) - Msg3 시점: RAR 내 UL Grant가 지정하는 슬롯/심볼

(2) FR2 예: μ = 3 (120 kHz), C0/C2 포맷

FR2에서는 슬롯이 훨씬 짧고(0.125ms 단위), PRACH와 SSB가 빔 단위로 매핑됩니다.

Slot s (DL)

├─ 여러 Beam에 대해 SSB Burst (Beam sweeping)

└─ UE는 모든 SSB 측정 후 SSB#k 선택

Slot s+Δ1 (UL)

├─ Beam k에 대응하는 PRACH RO (C0/C2)

│ → Msg1 전송 (짧은 preamble, 고 SCS)

└─ 다른 빔용 RO는 다른 시간/주파수에 존재

Slot s+Δ2 .. s+Δ2+W

├─ DL Beam k: Msg2(RAR) 송신

└─ UE: 동일 빔에서 PDCCH/PDSCH 모니터링

이후

├─ Beam k 기반 PUSCH (Msg3)

└─ Beam k 기반 PDSCH (Msg4)

→ FR2에서는 슬롯/심볼 타이밍 + 빔/SSB 매핑이 함께 맞아야 하므로,

RA 실패 분석 시 Time + Beam + Format을 동시에 봐야 합니다.

PUCCH (Physical Uplink Control Channel)

PUCCH는 단말(UE) 이 기지국(gNB) 에게 제어 정보를 보내는 핵심 채널입니다.

즉, 데이터 채널(PUSCH)이 아닌 “제어 신호만을 전송” 하는 채널이에요.

** PUCCH란 무엇인가?**

PUCCH (Physical Uplink Control Channel) 는

단말(UE)이 gNB로 제어 정보(Uplink Control Information, UCI) 를 전송하는 물리 업링크 제어 채널입니다.

즉,

“UE → gNB로 ACK/NACK, CSI, Scheduling Request 같은 신호를 보내는 통로”입니다.

** PUCCH의 주요 기능 (Uplink Control Information)**

| 제어 정보 종류 | 약어 | 설명 |

|---|---|---|

| HARQ Acknowledgement | HARQ-ACK | 다운링크 데이터(PDSCH)에 대한 수신 응답 (ACK/NACK) |

| Scheduling Request | SR | UE가 업링크 전송 자원을 요청 |

| Channel State Information | CSI | 채널 품질(CQI, PMI, RI 등)을 보고 |

| Hybrid 정보 조합 | UCI | 위의 여러 정보를 하나로 합쳐 전송 가능 |

즉, PUCCH은 ACK/NACK + SR + CSI 등을 단독 또는 조합으로 전송할 수 있습니다.

** PUCCH vs PUSCH 비교**

| 구분 | PUCCH | PUSCH |

|---|---|---|

| 용도 | 제어 정보 전송 | 사용자 데이터 전송 |

| 전송 시점 | 슬롯 끝, 짧은 기간 | 슬롯 전체, 긴 기간 |

| 데이터 종류 | ACK/NACK, SR, CSI 등 | 사용자 데이터, HARQ 재전송 |

| 대역폭 | 적음 (1~16 RB) | 큼 (여러 PRB 할당 가능) |

| 변조 방식 | BPSK, QPSK | QPSK ~ 256QAM |

| 코드율 | 낮음 (신뢰성 중시) | 높음 (전송량 중시) |

** PUCCH의 구성 요소**

PUCCH 전송은 항상 다음 요소로 정의됩니다 👇

| 항목 | 설명 |

|---|---|

| Resource Block (RB) | PUCCH가 점유하는 주파수 폭 |

| Symbol Duration | 점유하는 OFDM symbol 수 |

| Cyclic Prefix (CP) | 긴/짧은 CP 설정 |

| DMRS | 복조 참조신호 포함 (Demodulation Reference Signal) |

| Mapping Type | 주파수/시간 배치 방식 (format에 따라 다름) |

** PUCCH Format (형식)**

5G NR에서는 전송되는 제어정보의 크기(UCI bits)에 따라 5가지 형식으로 구분됩니다.

| 형식 | UCI 길이 | 특징 | 전송 자원(Time–Freq) |

|---|---|---|---|

| Format 0 | 1~2 bits | 짧은 ACK/NACK (mini-slot) | 1~2 symbols, 1 RB |

| Format 1 | 1~2 bits (긴 버전) | 긴 시간에 반복 전송 | 4~14 symbols, 1 RB |

| Format 2 | 3~170 bits | 중간 크기 (CSI 포함 가능) | 1~2 RB, 4~14 symbols |

| Format 3 | 170~300 bits | 대용량 CSI 보고 | 여러 RB, 4~14 symbols |

| Format 4 | 다수의 UCI 조합 | 다중 UCI 보고용 | 여러 RB, 4~14 symbols |

📘 요약

-

Format 0~1: 짧고 간단한 제어 (ACK/NACK, SR)

-

Format 2~4: CSI 등 긴 제어정보

** PUCCH Mapping (시간–주파수 배치)**

PUCCH는 PUCCH Resource 라는 구조로 할당됩니다.

이 자원은 PUCCH Format에 따라 배치 방식이 다릅니다.

예시 (시간–주파수 평면)

Frequency ↑

│

│ +----------------------------+

│ | PUCCH Format 1 | (4–14 symbols)

│ +----------------------------+

│ | DMRS 포함 (중간) |

│ +----------------------------+

│──────────────────────────────→ Time

-

Format 0: 짧은 mini-slot (1~2 symbols)

-

Format 1~4: 긴 duration (4~14 symbols)

-

DMRS는 항상 중간 symbol에 위치하여 복조 기준 제공

** PUCCH 자원(Resource) 구성 파라미터**

PUCCH 자원은 RRC를 통해 구성됩니다.

3GPP 38.213 §9.2.1에 정의된 주요 파라미터는 다음과 같습니다.

| 파라미터 | 의미 |

|---|---|

| PUCCH Resource ID | UE에 할당된 PUCCH 식별 번호 |

| Format Type | 0~4 |

| Start PRB | 주파수 시작 위치 |

| n_Symb | 사용 심볼 수 |

| Start Symbol Index | 시간 시작 위치 |

| DMRS Position | DMRS 심볼 위치 |

| Group Hopping / Sequence Hopping | 주파수 다양성 제공 |

| Spreading Factor (SF) | 코드 확산 정도 |

** 변조 및 스프레딩**

PUCCH은 UCI bit 수에 따라 다른 변조를 사용합니다.

| 전송 비트 수 | 변조 방식 |

|---|---|

| 1~2 bits | BPSK |

| ≥3 bits | QPSK |

| 다중 비트 + 확산 | OCC (Orthogonal Cover Code) 적용 |

또한 frequency hopping 또는 sequence hopping을 적용하여 채널 페이딩에 강하게 설계됩니다.

** 예시 — HARQ ACK 전송 절차**

1️. UE가 PDSCH 수신

2️. CRC → Pass → ACK, Fail → NACK

3️. UCI = 1 bit로 생성

4️. gNB가 미리 구성한 PUCCH Format 0 Resource에 맵핑

5️. BPSK 변조 → DMRS 포함 → 송신

6️. gNB는 해당 PUCCH 자원에서 ACK/NACK 수신 및 복조

** 핵심 요약**

| 항목 | 설명 |

|---|---|

| 이름 | PUCCH (Physical Uplink Control Channel) |

| 역할 | UE → gNB 제어정보 전송 (HARQ-ACK, SR, CSI 등) |

| 위치 | Uplink 주파수 대역 내 |

| 변조 방식 | BPSK / QPSK |

| 포맷 수 | 5가지 (Format 0~4) |

| DMRS 포함 여부 | 항상 포함 |

| 참조 문서 | 3GPP TS 38.211 §6.3.2, 38.213 §9.2 |

CSI-RS (Channel State Information Reference Signal)

CSI-RS는 “기지국(gNB)이 단말(UE)에게 보내는 채널 상태 측정용 신호”입니다.

즉, UE가 채널 품질을 평가하고 피드백(예: CQI, PMI, RI)을 보낼 수 있도록 하는 기준 신호예요.

🧭 정의

CSI-RS (Channel State Information Reference Signal) 는

UE가 무선 채널 상태(Channel State Information) 를 추정할 수 있도록

gNB가 다운링크 방향으로 전송하는 참조 신호(Reference Signal) 입니다.

즉,

“이 신호를 통해 단말이 현재 무선 채널이 얼마나 좋은지, 어떤 빔이 최적인지 판단한다.”

CSI-RS의 주요 목적

| 목적 | 설명 |

|---|---|

| ① 채널 품질 측정 (CQI) | UE가 SNR·SINR 측정 후 MCS 결정에 활용 |

| ② 빔 관리 (Beam Management) | 빔 스위칭, 트래킹, 리포팅 |

| ③ PMI 계산 (Precoding Matrix Indicator) | UE가 최적 precoder 선택 |

| ④ RI 결정 (Rank Indicator) | 다중 스트림 수 결정 |

| ⑤ 링크 적응 (Link Adaptation) | gNB가 전송 파라미터 최적화 (MCS, Layer 수 등) |

CSI-RS와 DMRS의 차이

| 구분 | CSI-RS | DMRS |

|---|---|---|

| 목적 | 채널 품질 측정, 피드백용 | 복조(demodulation)용 |

| 전송 주체 | gNB → UE | gNB → UE (DL), UE → gNB (UL) |

| 수신자 | UE | 데이터 수신 UE |

| 전송 시점 | 주기적 / 비주기적 | 데이터 전송 시 항상 포함 |

| 참조 범위 | 전체 채널 (beam별, 주파수별) | 해당 PDSCH / PUSCH에 국한 |

📘 요약:

- DMRS: 데이터 신호 복조용

- CSI-RS: 채널 품질 측정 및 피드백용

CSI-RS 전송 유형 (3GPP 38.211 §7.4.1.5)

| 종류 | 약어 | 설명 |

|---|---|---|

| Periodic CSI-RS | P-CSI-RS | 주기적으로 전송 (예: 5ms마다) |

| Semi-periodic CSI-RS | SP-CSI-RS | 특정 시점에만 반복 |

| Aperiodic CSI-RS | A-CSI-RS | 필요 시 on-demand로 전송 (DCI를 통해 트리거됨) |

💡 P-CSI-RS는 채널 모니터링용,

A-CSI-RS는 빔 측정·추적용으로 자주 사용됩니다.

CSI-RS 자원(Resource) 구성

CSI-RS는 시간–주파수–공간(안테나) 3차원 영역에서 정의됩니다.

| 파라미터 | 설명 |

|---|---|

| Resource ID | CSI-RS 자원의 식별 번호 |

| Density (주파수 밀도) | 1, 2, 4, 8 Subcarriers마다 1개 RE |

| Time Domain Position | 심볼 위치 (예: slot 내 symbol 2) |

| Resource Mapping | RE 맵핑 패턴 (CDM type, row, column 등) |

| CDM (Code Division Multiplexing) | 다중 UE 구분용 코드 확산 방식 |

| Power Control | 전송 전력 보정 (dBm 단위) |

시간–주파수 구조 예시

Frequency

↑

│

│ Subcarriers → ■ : CSI-RS RE

│

│ ┌────────────────────────────────┐

│ │■■ ■■ ■■ ■■ ■■ ■■ ■■ ■■ │ ← CSI-RS 자원 패턴 (density = 2)

│ ├────────────────────────────────┤

│ │ PDSCH (Data) │

│ └────────────────────────────────┘

│──────────────────────────────────────→ Time (OFDM Symbols)

- CSI-RS는 PDSCH 위나 그 주변의 특정 RE(Resource Element)에 삽입됨.

- UE는 이 신호를 수신하여 채널 응답(Amplitude, Phase)을 측정합니다.

CSI Measurement and Reporting 절차

1️. gNB → UE: CSI-RS 전송

2️. UE: CSI-RS 수신 후 채널 추정

3️. UE → gNB: 피드백 보고 (PUSCH 또는 PUCCH)

| 보고 항목 | 의미 |

|---|---|

| CQI | Channel Quality Indicator (채널 품질) |

| PMI | Precoding Matrix Indicator (최적 빔 선택) |

| RI | Rank Indicator (MIMO 스트림 수) |

| CSI-RS Resource Indicator | 사용한 CSI-RS 자원 ID |

CSI-RS의 역할 in Beam Management

5G NR에서 빔포밍은 SSB(SS Burst) 와 CSI-RS 기반으로 수행됩니다.

| 단계 | 역할 |

|---|---|

| 초기 빔 탐색 (SSB) | 셀 검색 및 초기 빔 선택 |

| 정밀 빔 추적 (CSI-RS) | 채널 업데이트 및 빔 트래킹 |

| 빔 유지 (Tracking) | 주기적 CSI-RS 수신 및 보고로 빔 유지 |

즉,

SSB는 coarse alignment,

CSI-RS는 fine adjustment 역할을 합니다.

CSI-RS 자원 타입 (Type 0 / Type 1 / Type 2)

| 타입 | 특징 | 용도 |

|---|---|---|

| Type 0 | 고정된 주파수 패턴, 공용 사용 | 셀 브로드캐스트용 |

| Type 1 | 유연한 주파수·시간 배치 | UE-specific 측정용 |

| Type 2 | 고밀도 RE 패턴 | 고정밀 빔 측정용 (Massive MIMO) |

수식적 표현

CSI-RS는 주파수 도메인에서 다음과 같이 모델링됩니다:

\[r(k) = h(k) \cdot x_{CSI-RS}(k) + n(k)\]- $r(k)$: 수신 신호

- $h(k)$: 채널 응답 (CSI 추정 대상)

- $x_{CSI-RS}(k)$ 송신된 참조 신호

- $n(k)$: 잡음

UE는 $h(k) = \frac{r(k)}{x_{CSI-RS}(k)}$ 로 추정하여

채널 응답 벡터를 계산합니다.

핵심 요약

| 항목 | 설명 |

|---|---|

| 정의 | 채널 품질 측정을 위한 다운링크 참조 신호 |

| 전송 방향 | gNB → UE |

| 목적 | CQI/PMI/RI 피드백, 빔 관리, 링크 적응 |

| 전송 유형 | Periodic / Semi-periodic / Aperiodic |

| RE 밀도 | 1, 2, 4, 8 Subcarrier 간격 |

| 차이점 | DMRS는 복조용, CSI-RS는 측정용 |

| 표준 문서 | 3GPP TS 38.211 §7.4.1.5, 38.214 §5.2.1, 38.213 §10.2 |

CDM이란 무엇인가?

CDM (Code Division Multiplexing) 은

여러 CSI-RS 신호(서로 다른 안테나 포트에서 송신되는)를

서로 다른 코드(직교 코드) 로 구분하여

동일한 시간–주파수 자원(RE) 위에 중첩(multiplexing) 하는 방법입니다.

즉,

시간이나 주파수를 따로 나누지 않고, 코드로 분리하는 방식이에요.

왜 CDM이 필요한가?

5G NR에서는 하나의 셀에서 다수의 안테나 포트(N ports) 가 CSI-RS를 송신할 수 있습니다.

그런데,

만약 각 포트가 서로 다른 주파수나 시간에 송신하면 자원 낭비(resource inefficiency) 가 발생하죠.

그래서!

CDM을 이용하면 동일한 RE(시간+주파수) 위에서도 여러 포트의 신호를 서로 구분하여 송신 가능합니다.

CDM의 핵심 원리

CDM은 기본적으로 직교 코드(orthogonal code) 를 사용합니다.

예를 들어, 두 개의 안테나 포트가 있을 때

- 포트 1: ( +1, +1 )

- 포트 2: ( +1, -1 )

이렇게 두 코드 벡터를 사용하면, 수신단에서는 상호 직교(orthogonal)하므로

각 포트의 CSI-RS를 간섭 없이 복원할 수 있습니다.

수식으로 표현하면 👇

\(\text{Received signal} = c_1 \cdot x_1 + c_2 \cdot x_2\)

여기서

- $c_i$: 직교 코드 (예: [1, 1], [1, -1])

- $x_i$: 포트 i의 신호

수신단은 코드 상관(correlation)을 통해 각 포트 신호를 분리합니다.

CDM 적용 방식 (3GPP 38.211 §7.4.1.5.3)

CDM은 두 가지 주요 방식으로 적용됩니다.

| 구분 | 방식 | 설명 |

|---|---|---|

| CDM-Type 1 | Time-domain spreading (TDM-CDM) | 시간 축에서 직교 코드 적용 |

| CDM-Type 2 | Frequency-domain spreading (FDM-CDM) | 주파수 축에서 직교 코드 적용 |

(1) CDM-Type 1: Time-domain CDM

-

같은 주파수 RE에서 서로 다른 심볼(slot 내 다른 symbol)에 서로 다른 직교코드 적용

-

예:

- Symbol 2 → Port1 코드

[+1, +1] - Symbol 3 → Port2 코드

[+1, -1]

- Symbol 2 → Port1 코드

이 방식은 시간축 자원을 두 심볼 이상 사용할 수 있을 때 사용됩니다.

Time →

│

│ Symbol 2: +1 +1

│ Symbol 3: +1 -1

│

│ Frequency ↑

→ 두 포트가 서로 다른 코드 시퀀스로 전송되어 상호 간섭하지 않음.

🔹 (2) CDM-Type 2: Frequency-domain CDM

- 같은 OFDM symbol 내에서 인접한 subcarrier 간에 직교코드를 적용.

- 예: 4개 서브캐리어(12kHz 간격)에 Walsh 코드 사용.

Frequency →

│

│ +1 +1 +1 +1 (Port 1)

│ +1 -1 +1 -1 (Port 2)

│ +1 +1 -1 -1 (Port 3)

│ +1 -1 -1 +1 (Port 4)

→ 포트 간 간섭이 없으며, 같은 시간 RE 내에서 병렬 CSI-RS 송신 가능.

CDM Grouping 개념

CDM을 실제 구현할 때는 포트를 “그룹” 단위로 묶습니다.

3GPP에서는 다음과 같은 구조를 정의합니다 👇

| Group ID | 포트 수 | CDM 타입 | 설명 |

|---|---|---|---|

| Group 0 | 2 | Type 1 | Time-domain CDM |

| Group 1 | 4 | Type 2 | Frequency-domain CDM |

| Group 2 | 8 | Type 2 | 고밀도 MIMO용 |

- 한 CSI-RS 자원 내에 여러 CDM Group 존재 가능

- 각 Group은 서로 다른 직교 코드 세트를 사용

예시: 4포트 CSI-RS 전송

| 포트 번호 | 코드 시퀀스 | 구분 |

|---|---|---|

| Port 3000 | [+1, +1, +1, +1] |

Group 0 |

| Port 3001 | [+1, -1, +1, -1] |

Group 0 |

| Port 3002 | [+1, +1, -1, -1] |

Group 1 |

| Port 3003 | [+1, -1, -1, +1] |

Group 1 |

→ 결과적으로 같은 심볼, 같은 주파수 자원을 사용하지만,

각 포트는 코드로 구분되어 UE는 간섭 없이 채널 추정 가능.

CDM 적용 후 CSI-RS 수신 모델

\[y(k) = \sum_{i=1}^{N_p} h_i(k) , c_i(k) , x_i(k) + n(k)\]- $N_p$: 포트 개수

- $h_i(k)$: 채널 응답

- $c_i(k)$: CDM 코드 (직교 시퀀스)

- $x_i(k)$: 송신된 CSI-RS 심볼

- $n(k)$: 잡음

UE는 $c_i(k)$ 와의 상관 연산으로 $h_i(k)$ 를 추정합니다.

CDM 적용 시 장점

| 항목 | 설명 |

|---|---|

| 주파수 자원 절약 | 여러 포트를 동일 RE에 중첩 가능 |

| 직교성 유지 | 포트 간 간섭 거의 없음 |

| 고효율 빔 측정 | 다수 빔을 동시에 측정 가능 |

| MIMO scalability | 대규모 안테나(64T64R)에도 적용 용이 |

요약 구조 도식

CSI-RS Ports (e.g., 4)

│

┌───────────────────────┐

│ CDM (Code Orthogonal) │

└───────────────────────┘

│

Shared REs (same time/frequency)

│

UE decodes via

Correlation (CDM codes)

핵심 요약

| 항목 | 설명 |

|---|---|

| 정의 | 여러 CSI-RS 포트를 코드로 구분하여 동일 자원에 다중화 |

| 목적 | 자원 효율 향상, 다중 빔 채널 추정 지원 |

| 방식 | Time-domain / Frequency-domain CDM |

| 코드 종류 | Walsh–Hadamard 직교 코드 |

| 이점 | 포트 간 간섭 없음, 높은 스펙트럼 효율 |

| 표준 문서 | 3GPP TS 38.211 §7.4.1.5.3 |

CSI Interference Measurement

기본 개념

CSI Interference Measurement 는

단말(UE)이 다운링크 간섭(interference)과 잡음(noise) 의 세기를 측정하여

채널 상태 정보(Channel State Information, CSI) 보고 시

정확한 CQI (Channel Quality Indicator)를 계산하기 위한 과정입니다.

즉 👇

“UE가 신호 세기(S)뿐만 아니라, 주변 간섭(I+N)까지 측정해서

실제 사용 가능한 SINR = S / (I+N) 을 평가하는 과정”이에요.

CSI 측정 구성요소

5G NR에서 CSI를 구성하는 세 가지 주요 측정 항목이 있습니다.

| 구성 요소 | 약어 | 설명 |

|---|---|---|

| CSI-RS Resource | Reference Signal | 신호 세기(Signal Power) 측정용 |

| CSI-IM Resource | Interference Measurement | 간섭/잡음 전력 측정용 |

| CSI Resource Set | 조합된 세트 | 특정 CSI-RS + CSI-IM 묶음 구성 |

CSI-RS vs CSI-IM

| 구분 | CSI-RS (Channel Measurement) | CSI-IM (Interference Measurement) |

|---|---|---|

| 측정 대상 | 유효 신호 (Signal Power, S) | 간섭 + 잡음 (Interference + Noise, I+N) |

| 용도 | 채널 응답 추정, PMI/RI 계산 | SINR 계산 시 분모(I+N) 산출 |

| 전송 내용 | 참조 신호 | 아무 신호 없음 (RE가 비워짐) |

| 표현 형태 | 실제 RS 전송 | Muted Resource (비어 있는 RE) |

| 표준 문서 | 3GPP 38.211 §7.4.1.5 | 3GPP 38.211 §7.4.1.6 |

즉 👇

CSI-RS는 “채널의 신호 세기(S)”를 측정하고,

CSI-IM은 “그 신호가 없는 상태의 간섭 전력(I+N)”을 측정합니다.

이 두 값을 함께 사용해서 SINR을 계산합니다.

CSI 간섭 측정의 수학적 표현

UE는 다음 식으로 SINR (Signal-to-Interference-plus-Noise Ratio) 을 계산합니다:

\[\text{SINR} = \frac{P_{\text{CSI-RS}}}{P_{\text{CSI-IM}}}\]| 항목 | 의미 |

|---|---|

| $P_{\text{CSI-RS}}$ | 특정 CSI-RS RE에서 측정한 평균 신호 전력 |

| $P_{\text{CSI-IM}}$ | CSI-IM (muted RE) 구간에서 측정한 간섭+잡음 전력 |

CSI Interference Measurement Resource (CSI-IM)

CSI-IM (Interference Measurement Resource) 는

“특정 RE(Resource Element)를 비워둔(Muted)” 상태로 구성되어,

UE가 이 RE의 배경 간섭 전력을 측정할 수 있도록 정의된 자원입니다.

CSI-IM은 PDSCH 데이터나 CSI-RS가 전송되지 않는 RE 를 지정합니다.

이 영역의 전력 세기는 곧 “간섭 + 잡음”입니다.

예시 (Time–Frequency grid)

Frequency

↑

│

│ ■■■■■■■■■■■■■■■■■■■■■■■ → CSI-RS 자원 (신호 전송 영역)

│ ▓▓▓▓▓▓▓▓▓▓▓▓▓▓▓▓▓▓▓▓▓▓▓▓ → CSI-IM 자원 (muted, 간섭 측정)

│──────────────────────────→ Time

CSI Resource Set 구성

CSI Interference Measurement은 항상 CSI Resource Set 의 일부로 정의됩니다.

| 구성요소 | 설명 |

|---|---|

| CSI-RS Resource Set | 채널 품질 측정용 자원 그룹 |

| CSI-IM Resource Set | 간섭 측정용 자원 그룹 |

| CSI Report Config | 두 자원을 매핑하여 CQI/PMI/RI 계산 시 사용 |

즉 👇

CSI Resource Set = { CSI-RS + CSI-IM }

실제 측정 절차

1️. gNB → UE: RRC(Reconfiguration)로 CSI-RS & CSI-IM 자원 설정

2️. UE:

- CSI-RS 구간에서 신호 세기 (P_S) 측정

- CSI-IM 구간에서 간섭 (P_I) 측정

3️. UE: SINR = ( P_S / P_I ) 계산

4️. UE → gNB: CQI, PMI, RI 보고 (PUCCH/PUSCH 경로)

CSI-IM의 전송 유형 (3GPP TS 38.211 §7.4.1.6)

| 유형 | 이름 | 설명 |

|---|---|---|

| Type 0 | Full bandwidth | 전체 대역에서 muted |

| Type 1 | Frequency-selective | 특정 RB 그룹만 muted |

| Type 2 | Beam-specific | 특정 빔 패턴에 해당하는 RE만 muted |

이를 통해 UE는 “대역별” 또는 “빔별” 간섭 레벨을 구분 측정할 수 있습니다.

측정 결과의 활용

CSI Interference Measurement 결과는 다음과 같은 링크 적응(Link Adaptation) 에 활용됩니다.

| 항목 | 역할 |

|---|---|

| CQI (Channel Quality Indicator) | MCS(Modulation and Coding Scheme) 선택 기준 |

| PMI (Precoding Matrix Indicator) | 최적 빔 방향 선택 |

| RI (Rank Indicator) | 다중 스트림 수 결정 |

| Beam Management | 간섭 낮은 빔 유지, 재선택 |

즉,

CSI-RS는 “신호 강도”,

CSI-IM은 “간섭 강도”를 알려주어

CQI = f(SINR) 계산의 기반을 제공합니다.

예시 수치

| 구분 | 값 (dBm) | 설명 |

|---|---|---|